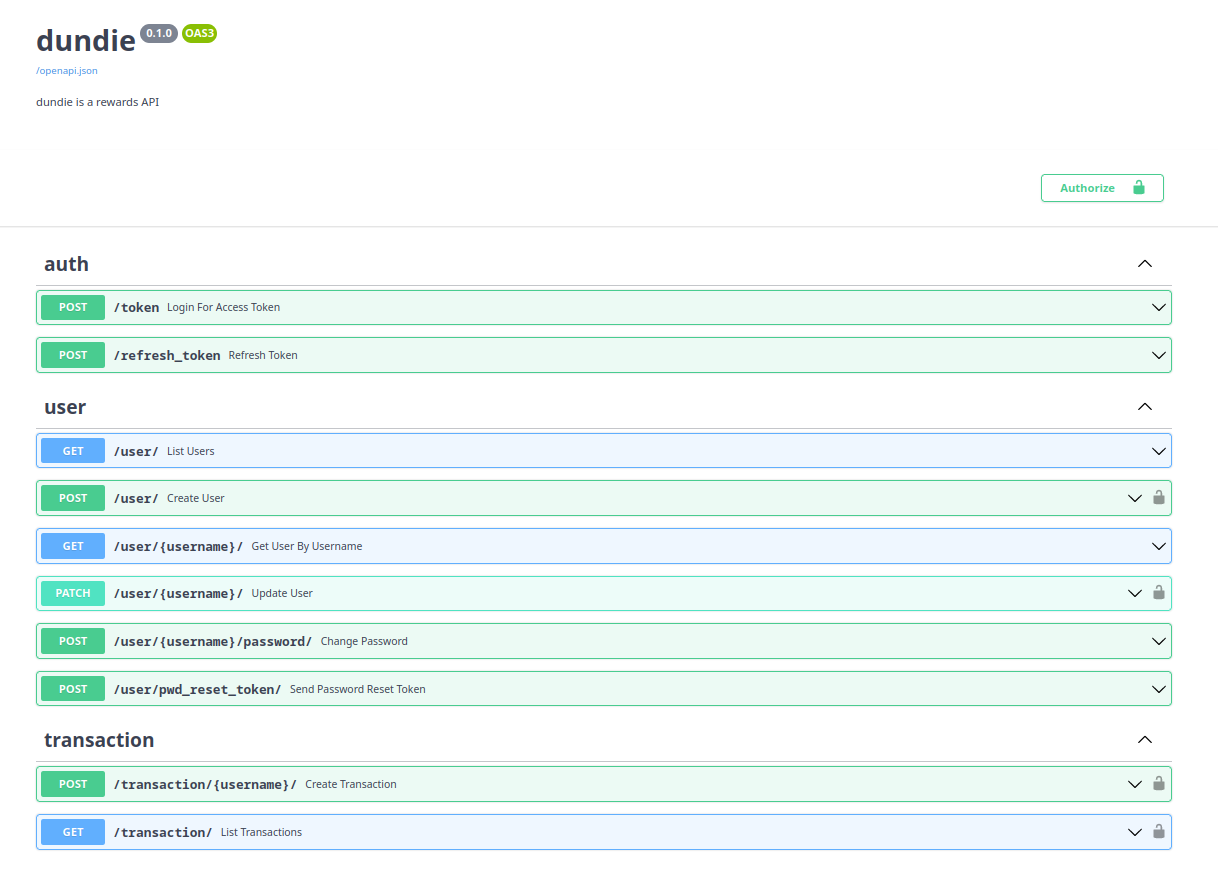

Projeto Dundie API

LINUXTips - Python Web API

Olá, este é o material de apoio do projeto desenvolvido durante o treinamento Python Web API para ter acesso aos videos e grupo de alunos + emissão do certificado clique no link e matricule-se.

Durante o treinamento, você vai aprender:

- Montar o ambiente de desenvolvimento

- Organizar as pastas do projeto

- Orquestrar os serviços com containers

- Modelar o banco de dados

- Fazer migração de dados

- Criar uma CLI para gerenciar o projeto

- Criar uma API com FastAPI

- Autenticar usuários com JWT

- Enviar e-mails com background tasks

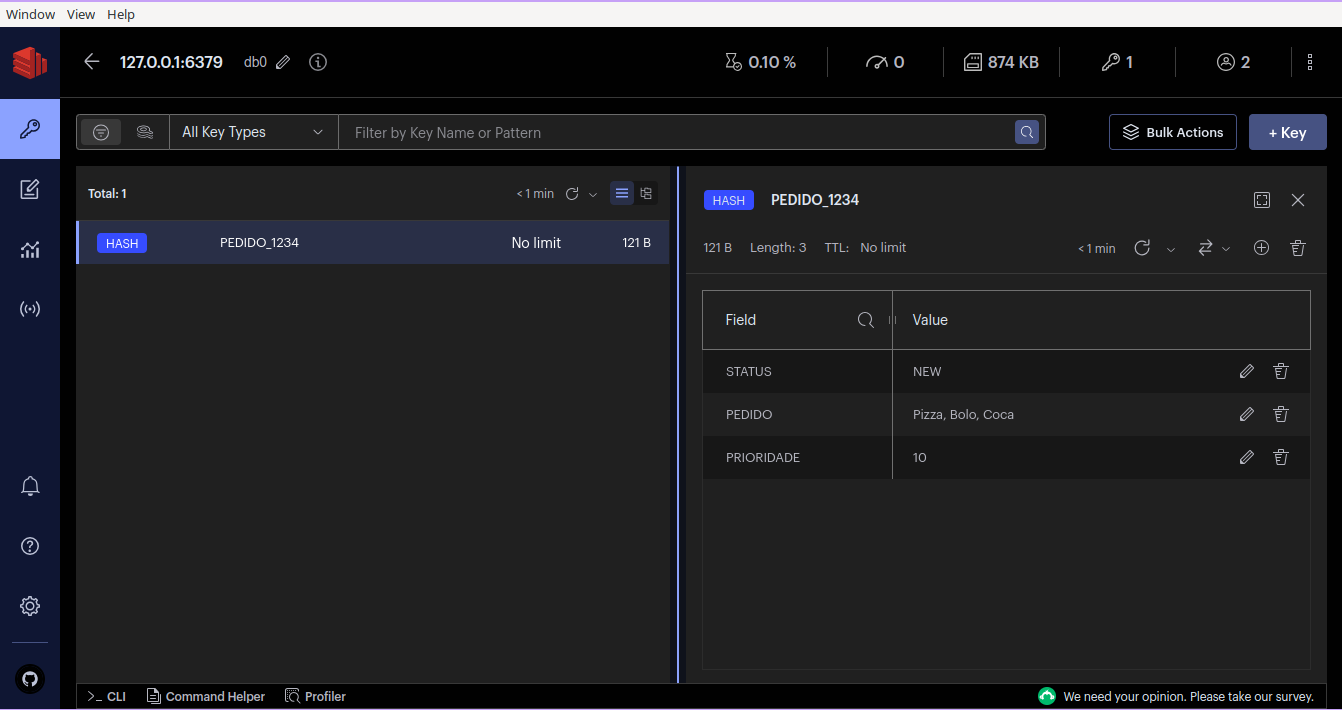

- Trabalhar com task queue

- Planejar testes

- Preparar um pipeline de testes

- Escrever testes automatizados

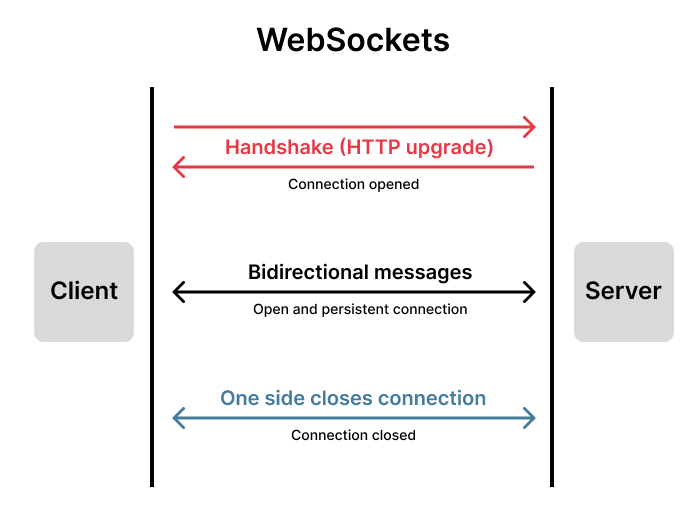

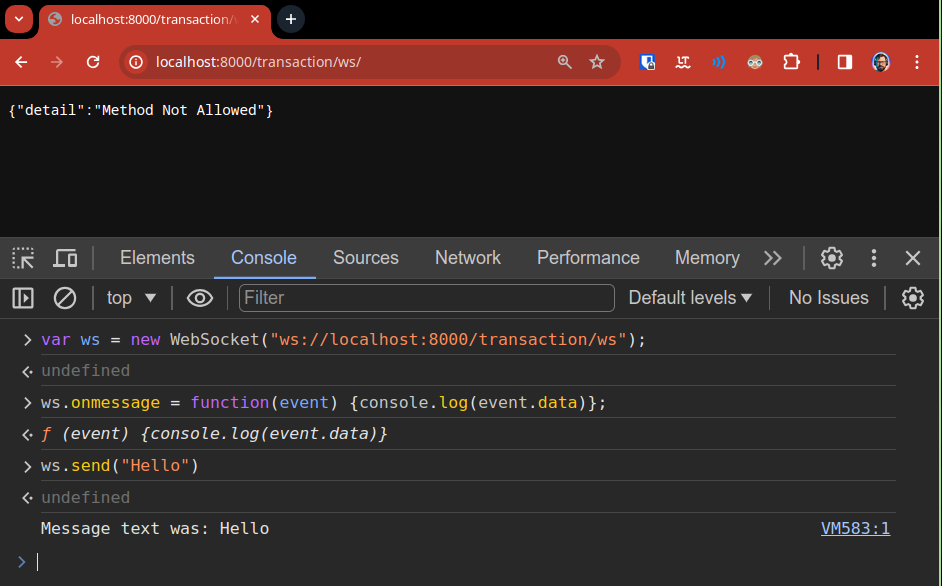

- Usar protocolo web-sockets

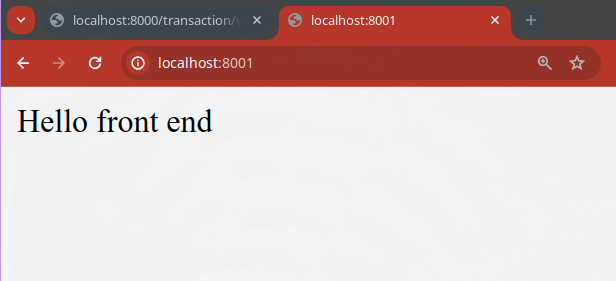

- Integrar com um Front-End

Se tiver qualquer dúvida não hesite em postar em nosso grupo do Discord, lá você vai obter ajuda do intrutor e também dos demais alunos. (O link para o grupo está no primeiro item lá na plataforma)

Ahh e se você não usa o Discord, não tem problema, pode acessar https://LINUXtips/social e postar lá aba referente ao treinamento.

Faça parte do Discord da LINUXtips cliando em Convite Discord Geral (observação: no discord existem salas públicas e uma sala exclusiva para alunos.)

Siga o autor deste treinamento no twitter Bruno Rocha

Tudo pronto para começar?

Você pode mudar o tema dessa página, caso prefira pro exemplo dark ou light theme clicando no ícone na barra superior.

commit 99412ec on 2024-09-13 23:44:08

Requisitos

Opção 1: Executando localmente

- Acesso a um computador com Python

- Terminal Linux/Mac (ou WSL)

- Docker e docker compose

- Editor de código de sua preferência (VSCode, vim, micro, emacs)

Durante as aulas em video o instrutor estará usando o editor vim mas você pode usar o editor de sua preferência.

Opção 2: Executando online no Gitpod

- Browser (Chrome ou Firefox)

- Conta no https://gitpod.io

A conta gratuita do gitpod oferece 50 horas por mês de uso e no ambiente já tem editor (VSCode), terminal Linux e containers, tudo isso rodando diretamenteem seu navegador.

Os comandos apresentados serão todos executados em um terminal Linux, se estiver no Windows recomendo usar o WSL, uma máquina virtual ou um container Linux, ou por conta própria adaptar os comandos necessários.

Repositório

Obtenha uma cópia do Repositório

- Faça login no github e faça um fork do respositório deste projeto clicando em:

Os blocos de código aqui apresentados que contém $ significam que é um comando que deve ser executado no terminal, o simbolo $ não faz parte do comando, este simbolo indica o prompt e provavelmente o seu terminal irá exibir $ ou algum caracter de marcação similar como > ou #.

É recomendado que você digite os comandos ao invés de copiar e colar, mas caso prefira copiar e colar lembre-se que o sinal de $ não precisa ser copiado.

Obtendo os arquivos

Opção 1: Rodando localmente em seu computador

Faça o clone o projeto para uma pasta no seu ambiente local usando git, substituindo USER pelo seu nome de usuário do github:

$ cd pasta/onde/vc/guarda/seus/projetos

$ git clone git@github.com:USER/dundie-api.git

$ cd dundie-api

Para clonar usando git@... você precisa ter seu git local configurado com chave ssh, caso contrário terá que clonar usando o endereço https://github.com/USER/dundie-api

Opção 2: Rodando no seu navegador com gitpod

Caso tenha optado por utilizar o gitpod basta acessar https://gitpod.io e efetuar o login utilizando sua conta do Github.

O gitpod irá criar um ambiente virtual para você, com tudo configurado para rodar o projeto e você terá acesso ao editor e ao terminal.

Ambiente de Desenvolvimento

Ambiente Dev é para fins de programação o conjunto de ferramentas, bibliotecas e variáveis que precisam estar disponíveis para desenvolver, testar e manter o projeto.

Preparando o Ambiente

Opção 1: Rodando no seu computador local

Dentro da pasta dundie-api e crie um ambiente virtual.

$ python -m venv .venv

E ative a virtualenv

No Linux/Mac ou Windows WSL

$ source .venv/bin/activate

No Windows Power Shell

$ .\venv\Scripts\activate.ps1

O ambiente virtual ativado fará com que seu terminal exiba (.venv) juntamente do prompt, você ainda pode digitar no terminal which python para confirmar se o ambiente está mesmo ativado, o output deverá ser [...]/.venv/bin/python

Opção 2: Rodando online com o gitpod

No gitpod.io não é preciso criar um abiente virtual, o ambiente já vem configurado isoladamente.

Instalando as dependências

Com o ambiente pronto podemos agora instalar as dependências básicas do projeto que estão contidas no arquivo requirements-dev.txt.

Confirme que o arquivo já contém a lista de todas as ferramentas que usaremos para fins de desenvolvimento e debugging, confira o conteúdo do arquivo abrindo em seu editor ou através do comando cat no terminal Linux.

$ cat requirements-dev.txt

ipython # terminal

ipdb # debugger

sdb # debugger remoto

pip-tools # lock de dependencias

pytest # execução de testes

pytest-order # ordenação de testes

httpx==0.26.0 # requests async para testes

black # auto formatação

flake8 # linter

Instalaremos as dependencias com a ferramenta pip que é um módulo do Python.

-

Atualizamos o pip

$ python -m pip install --upgrade pip -

Instalamos as dependencias de desenvolvimento

$ python -m pip install -r requirements-dev.txt -

Instalamos o projeto em modo de desenvolvimento.

Esta instalação permite maior facilidade nos testes e auto-complete do editor de código

$ python -m pip install -e ".[dev]"

Os metadados de instalação estão definidos no arquivo pyproject.toml, neste arquivo estão listados os atributos do projeto, os arquivos e módulos que fazem parte, a versão e as dependencias.

O problema que vamos resolver

A Dunder Mifflin é a maior e mais bem sucedida empresa de papéis do mundo

Este é Michael Scott, gerente regional da Dunder Mifflin de Scranton, Pensilvania.

Ele se acha o melhor gerente do mundo, mas na verdade é bem sem graça e as vezes até inconveniente.

Este é o time de funcionários que o Michael gerencia, eles estão com cara de alegres (com excessão da Angela), porém nem todos estão felizes, eles estão na verdade bastante desmotivados e começaram a reclamar das piadas sem graça do Michael e da falta de reconhecimento da empresa.

Projeto Dundie Rewards

A Dunder Mifflin nos contratou para desenvolver uma API para o novo projeto Dundie Rewards, que consiste em um sistema de recompensas onde cada funcionário terá uma conta e irá ganhar pontos.

Esses pontos poderão ser atribuidos pelo Michael quando ele achar que um funcionário merece, automaticamente em datas especiais ou em batimento de metas, e os funcionários poderão trocar pontos entre eles como forma de reconhecimento do trabalho dos colegas.

Ao final do ano, os funcionários vão poder trocar seus pontos por dinheiro para gastar como quiserem.

Vamos começar este projeto desenvolvendo a estrutura de pastas, a orquestração do ambiente, a modelagem de dados e a API.

Futuramente na fase 2 iremos integrar com um front-end.

Funcionalidades

Usuários

- Registro de novos funcionários via CLI e via API

- CLI:

dundie create-user [Nome] [Email] [Password Inicial] [departamento] - API:

POST /user/ data={nome:.., email:.., departamento:.., password:..} - Usuários do departamento

managementsão considerados super usuáripos - O

usernameé gerado a partir do slug do nome do usuárioPam Besly->pam-besly

- CLI:

- Autenticação de usuários com JWT token

- Para usar a API será necessário uma chamada

GET /token data={username, password}e todas as chamadas subsequentes precisarão do token informado nosHEADERS.

- Para usar a API será necessário uma chamada

- O usuário pode requisitar um token para alteração de senha

Transações

- Transações não podem ser deletadas ou canceladas, cada transação é um item no histórico da conta do usuário em questão.

- Qualquer usuário com um token poderá fazer uma chamada para

POST /transaction/username/ data={value=100}esta chamada adiciona um novo registro na tabelaTransactioncontentouser_id: <usuario_dono_da_conta>, from_id: <usuário que fez o depósito>, value: <integer>, date: <timestamp> - O usuário só poderá fazer uma transação caso o saldo da sua própria conta seja suficiente para cobrir o custo da transação.

- O saldo de um usuário é a soma de todas as suas transações.

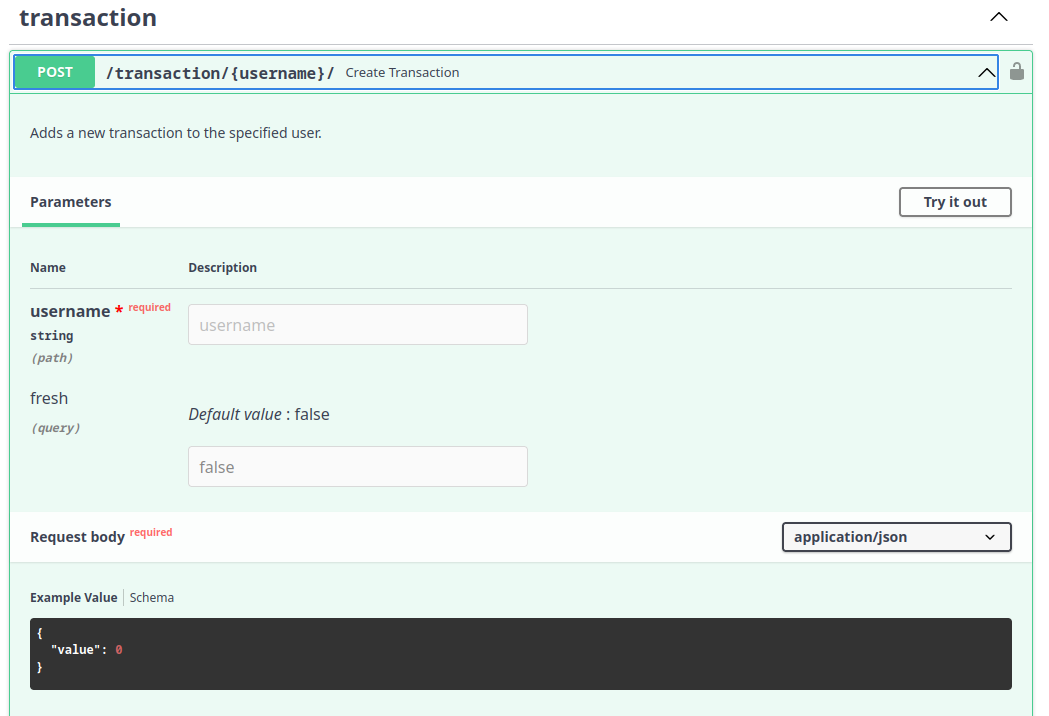

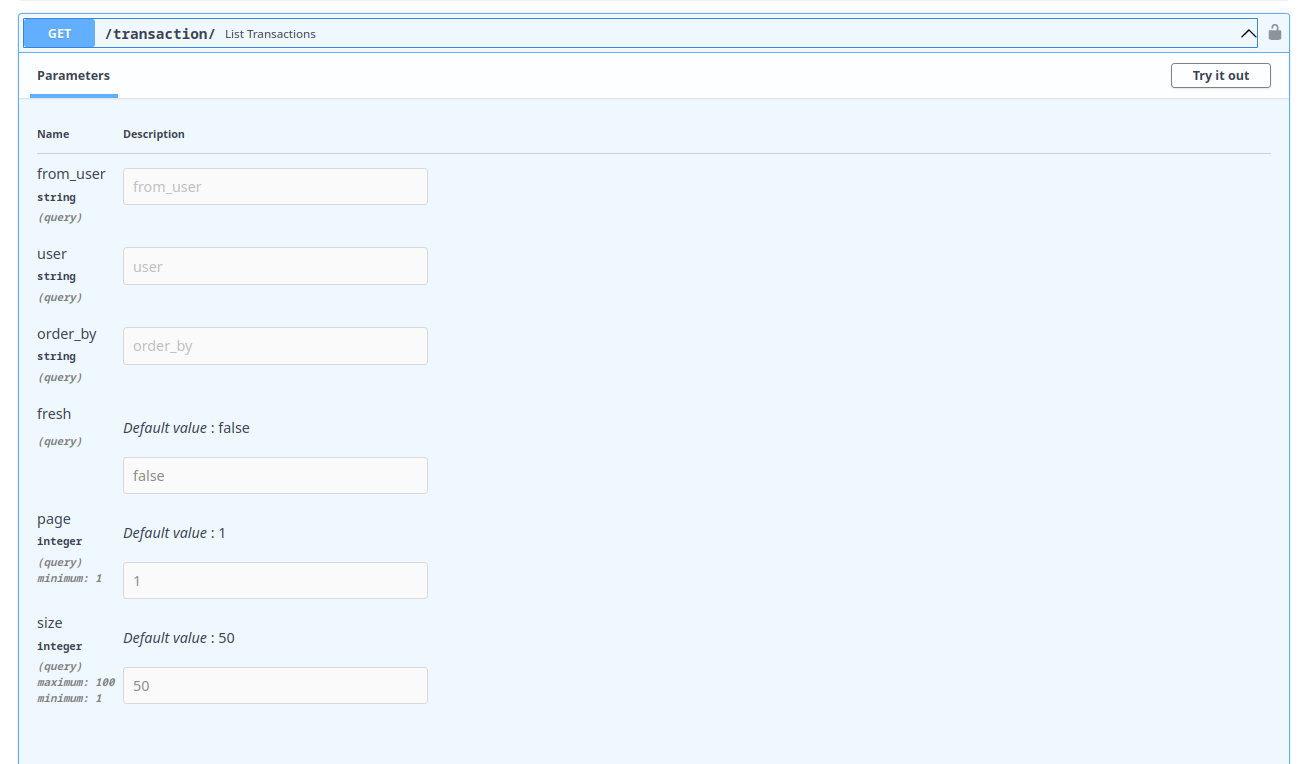

Endpoints:

POST /transaction/username/- Registra uma transação para um usuário- Acesso:

Geral - Validação: O usuário autenticado é o

from_idda transação e deve ter saldo suficiente.

- Acesso:

GET /transaction/username/- Retorna as transações de um usuário incluindo seubalance(saldo todal)- Acesso:

Managerouusername == current_user

- Acesso:

GET /transaction/- Retorna todas as transações

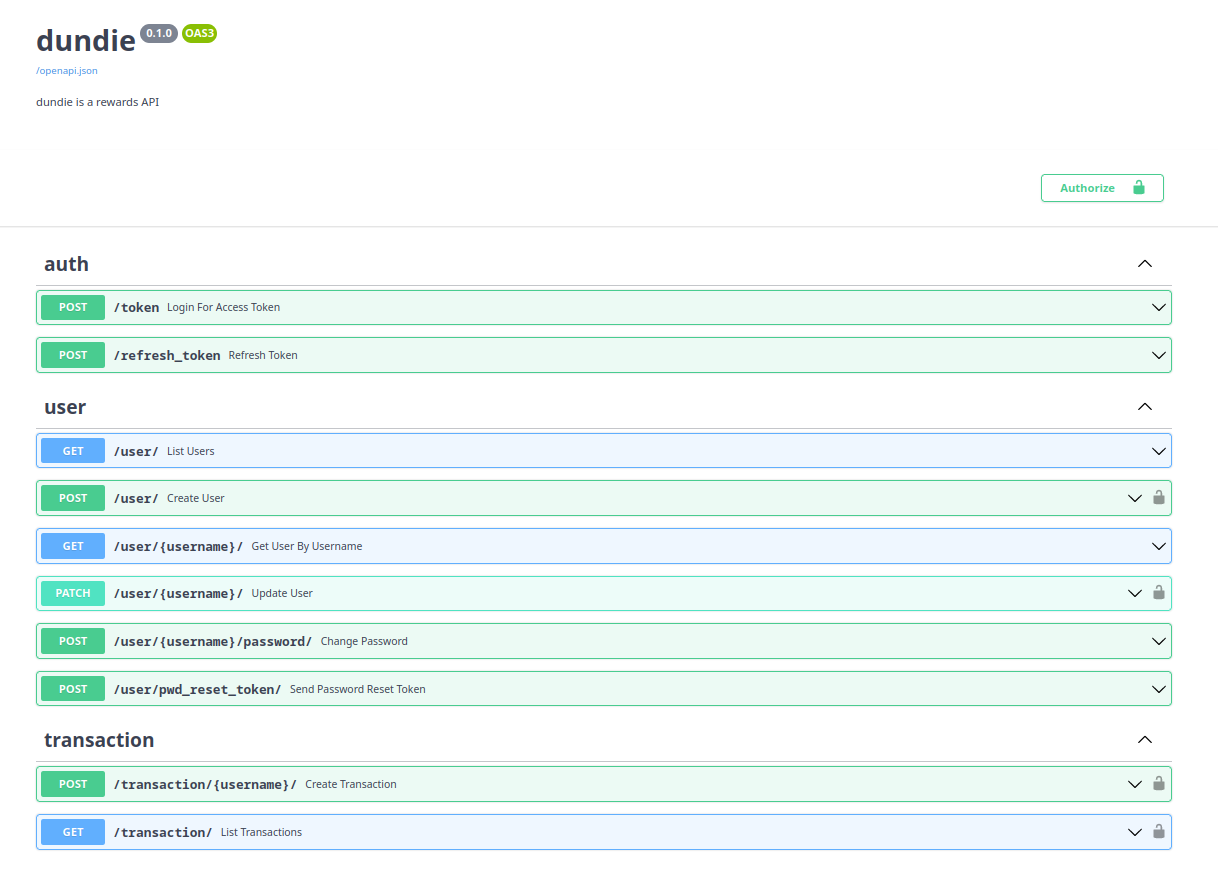

API Spec

Arquitetura

Fase 1

- 1 Serviço de API

- 1 Serviço de Banco de Dados

graph LR;

A["API (FastAPI) fa:fa-globe"]

B[("Banco de Dados (PG) fa:fa-cubes")]

A --> B

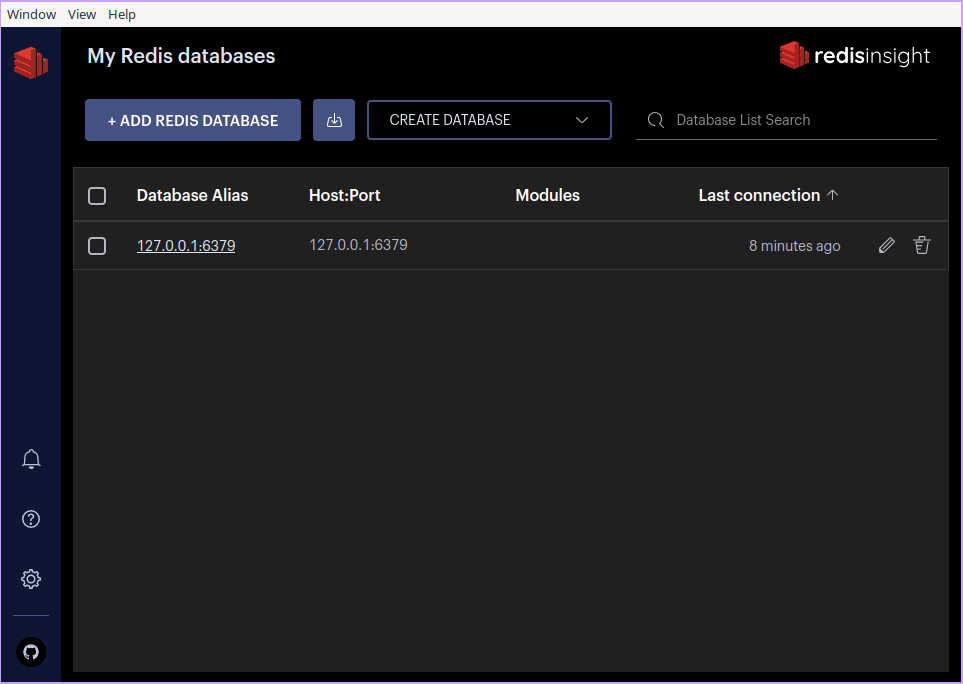

Fase 2

- 1 Serviço de API

- 1 Serviço de Banco de Dados

- 1 Serviço consumidor de tarefas (RQ)

- 1 Serviço de fila de mensagens (Redis)

graph TD;

A["API (FastAPI) fa:fa-globe"]

B[("Banco de Dados (PG) fa:fa-cubes")]

C>"Fila de mensagens (Redis) fa:fa-bars"]

D[["Consumidor de tarefas (RQ) fa:fa-gears"]]

A --> B

A --> C

D --> C

D --> B

Agora vamos ver como será a estrutura dos arquivos -->

Estrutura de arquivos

Esta é estrutura deste repositório, os arquivos com * são os que você vai precisar editar ao longo deste guia.

$ tree --filesfirst -L 3 -I docs

.

├── docker-compose.yaml # Container Orchestration

├── Dockerfile.dev # Container Dev Image

├── MANIFEST.in # Arquivos do projeto

├── pyproject.toml # Metadados do projeto

├── requirements-dev.txt # Dev tools

├── requirements.in # Dependencies

├── settings.toml # Config por ambiente

├── setup.py # Setuptools bootstrap

├── test.sh # CI Pipeline

├── dundie # Main Package

│ ├── app.py* # FastAPI app

│ ├── auth.py* # Token JWT

│ ├── cli.py* # CLI app

│ ├── config.py # Config management

│ ├── db.py* # Database connection

│ ├── default.toml # Default settings

│ ├── __init__.py

│ ├── security.py* # Password Hashing

│ ├── VERSION.txt # SCM versioning

│ ├── models

│ │ ├── __init__.py*

│ │ ├── transaction.py* # Models for transaction

│ │ └── user.py* # Models for User

│ ├── routes

│ │ ├── auth.py* # Token and Auth URLs

│ │ ├── __init__.py*

│ │ ├── transaction.py* # Transaction URLs

│ │ └── user.py* # User URLs

│ └── tasks

│ ├── __init__.py*

│ ├── transaction.py* # Transaction Taks

│ └── user.py* # User Tasks

├── postgres

│ ├── create-databases.sh # DB startup

│ └── Dockerfile # DB image

└── tests

├── conftest.py* # Pytest config

├── __init__.py

└── test_api.py* # API tests

Todos os arquivos acima já estão criados no repositório, você vai precisar apenas editar,

alguns arquivos como o .secrets.toml (para guardar dados sensiveis) você irá criar localmente

pois este arquivo não deverá ser comitado ao repositório.

Criando uma API base

Vamos editar o arquivo dundie/app.py e colocar a minima aplicação FastAPI

só para que possamos rodar o container e testar se tudo está funcionando.

dundie/app.py

from fastapi import FastAPI

app = FastAPI(

title="dundie",

version="0.1.0",

description="dundie is a rewards API",

)

Salve as alterações e agora vamos partir para a definição do container ->

Criando um container

Vamos agora verificar o Dockerfile.dev que está na raiz do repositório e será a imagem responsável por executar nossa api.

Dockerfile.dev

# Build the app image

FROM python:3.10

# Create directory for the app user

RUN mkdir -p /home/app

# Create the app user

RUN groupadd app && useradd -g app app

# Create the home directory

ENV APP_HOME=/home/app/api

RUN mkdir -p $APP_HOME

WORKDIR $APP_HOME

# install

COPY . $APP_HOME

RUN pip install -r requirements-dev.txt

RUN pip install -e .

RUN chown -R app:app $APP_HOME

USER app

CMD ["uvicorn","dundie.app:app","--host=0.0.0.0","--port=8000","--reload"]

O arquivo acima define o passo a passo para construir uma imagem de container customizada a partir da python:3.10, neste script de cosntrução da imagem estamos criando diretórios, ajustando permissões, copiando arquivos da aplicação e isntalando dependencias, além de definirmos o comando principal de execução do programa.

Com esta definição pronta o próximo passo é construir a imagem do container:

docker build -f Dockerfile.dev -t dundie:latest .

Agora em nosso sistema teremos uma imagem chamada dundie com a tag latest e podemos executar.

$ docker run --rm -it -v $(pwd):/home/app/api -p 8000:8000 dundie

INFO: Will watch for changes in these directories: ['/home/app/api']

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

INFO: Started reloader process [1] using StatReload

INFO: Started server process [8]

INFO: Waiting for application startup.

INFO: Application startup complete.

Acesse: http://0.0.0.0:8000/docs e terá acesso a página default da OpenAPI spec que acompanha o FastAPI.

Ainda não temos rotas definidas portanto podemos passar o próximo passo.

Orquestrando serviços

Os serviços:

graph LR;

A["API (FastAPI) fa:fa-globe"]

B[("Banco de Dados (PG) fa:fa-cubes")]

A --> B

Docker compose

Para iniciar a nossa API + o Banco de dados vamos precisar de um orquestrador de containers, em produção isso será feito com Kubernetes mas no ambiente de desenvolvimento podemos usar o docker compose.

No arquivo docker-compose.yaml

- Definimos 2 serviços

apiedb - Informamos os parametros de build com os dockerfiles

- Na

apiabrimos a porta8000 - Na

apipassamos 2 variáveis de ambienteDUNDIE_DB__urieDUNDIE_DB_connect_argspara usarmos na conexão com o DB - Marcamos que a

apidepende dodbpara iniciar. - No

dbinformamos o setup básico do postgres e pedimos para criar 2 bancos de dados, um para a app e um para testes.

docker-compose.yaml

version: '3.9'

services:

api:

build:

context: .

dockerfile: Dockerfile.dev

ports:

- "8000:8000"

environment:

DUNDIE_DB__uri: "postgresql://postgres:postgres@db:5432/${DUNDIE_DB:-dundie}"

DUNDIE_DB__connect_args: "{}"

SQLALCHEMY_SILENCE_UBER_WARNING: 1

volumes:

- .:/home/app/api

depends_on:

- db

stdin_open: true

tty: true

db:

build: postgres

image: dundie_postgres-13-alpine-multi-user

volumes:

- dundie_pg_data:/var/lib/postgresql/data

ports:

- "5432:5432"

environment:

- POSTGRES_DBS=dundie, dundie_test

- POSTGRES_USER=postgres

- POSTGRES_PASSWORD=postgres

volumes:

dundie_pg_data:

O próximo passo é estando na raiz do repositório executar:

docker compose up -d

Para verificar os serviços que estão rodando:

$ docker compose ps

Name Command State Ports

api_1 /bin/sh -c uvicorn dundie... Up 8000

db_1 docker-entrypoint.sh postgres Up 5432

Os serviços ficarão em execução em segundo plano, se quiser manter o terminal aberto para acompanhar os logs pode omitir o -d ou então abrir um segundo terminal e executar docker compose logs --follow

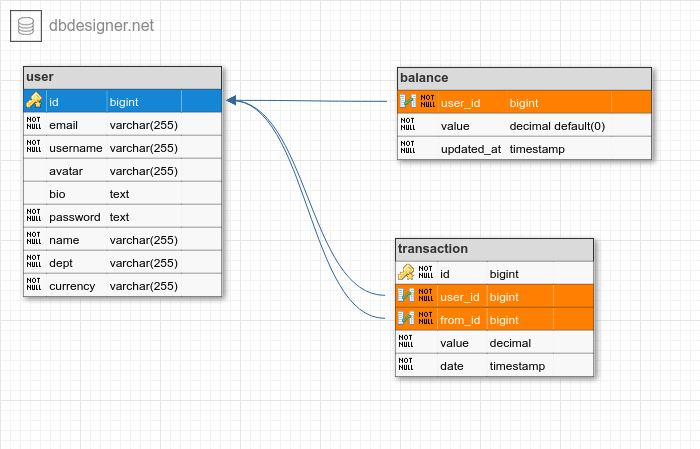

Modelagem

Definindo os models com Pydantic

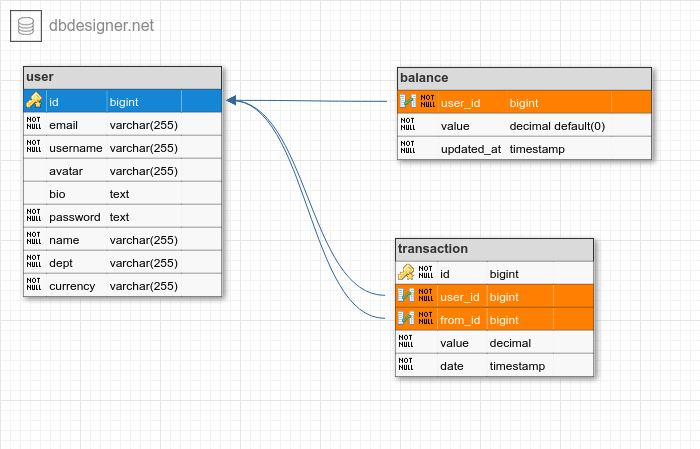

Esta será a modelagem do banco de dados completo, mas começaremos apenas com a tabela de usuários.

https://dbdesigner.page.link/GqDU95ApwZs7a9RH9

Vamos modelar o banco de dados definido acima usando o SQLModel, que é uma biblioteca que integra o SQLAlchemy e o Pydantic e funciona muito bem com o FastAPI.

Vamos começar a estruturar os model principal para armazenar os usuários

EDITE o arquivo dundie/models/user.py

"""User related data models"""

from typing import Optional

from sqlmodel import Field, SQLModel

class User(SQLModel, table=True):

"""Represents the User Model"""

id: Optional[int] = Field(default=None, primary_key=True)

email: str = Field(unique=True, nullable=False)

username: str = Field(unique=True, nullable=False)

avatar: Optional[str] = None

bio: Optional[str] = None

password: str = Field(nullable=False)

name: str = Field(nullable=False)

dept: str = Field(nullable=False)

currency: str = Field(nullable=False)

@property

def superuser(self):

""""Users belonging to management dept are admins."""

return self.dept == "management"

Para que seja possivel importar e o SQLAlchemy reconhecer o nosso objeto EDITE arquivo dundie/models/__init__.py adicione

from sqlmodel import SQLModel

from .user import User

__all__ = ["User", "SQLModel"]

NOTA as tabelas Balance e Transaction iremos definir posteriormente.

Agora podemos nos conectar com o banco de dados ->

Configurações

Agora que temos pelo menos uma tabela mapeada para uma classe precisamos estabelecer conexão com o banco de dados e para isso precisamos carregar configurações

Verifique o arquivo dundie/default.toml

[default]

[default.db]

uri = ""

connect_args = {check_same_thread=false}

echo = false

Lembra que no docker-compose.yaml passamos as variáveis DUNDIE_DB...

aquelas variáveis vão sobrescrever os valores definidos no default.toml, por exemplo, DUNDIE_DB__uri=... irá preencher o valor uri na seção [default.db] do arquivo default.toml

Para carregar as configurações vamos usar o plugin dynaconf que já está instalado e só precisamos carregar criando uma instancia de settings que será o objeto usado durante toda a aplicação para acessar as configurações:

Veja em dundie/config.py como estamos inicializando o plugin de configurações.

"""Settings module"""

import os

from dynaconf import Dynaconf

HERE = os.path.dirname(os.path.abspath(__file__))

settings = Dynaconf(

envvar_prefix="dundie",

preload=[os.path.join(HERE, "default.toml")],

settings_files=["settings.toml", ".secrets.toml"],

environments=["development", "production", "testing"],

env_switcher="dundie_env",

load_dotenv=False,

)

No arquivo acima estamos definindo que o objeto settings irá

carregar variáveis do arquivo default.toml e em seguida dos arquivos

settings.toml e .secrets.toml e que será possivel usar DUNDIE_ como

prefixo nas variáveis de ambiente para sobrescrever os valores.

Agora já podemos acessar esses valores e criar a conexão com o banco de dados -->

Conexão com o DB

Para conectar com o banco de dados, precisamos criar um objeto engine, este objeto armazena as configurações

como o endereço do banco, usuário e senha. O objeto engine é o responsável por executar as consultas SQL que

usaremos para definir as tabelas e também para consultar e alterar dados.

EDITE o arquivo dundie/db.py e deixe conforme o código abaixo:

dundie/db.py

"""Database connection"""

from sqlmodel import create_engine

from .config import settings

engine = create_engine(

settings.db.uri, # pyright: ignore

echo=settings.db.echo, # pyright: ignore

connect_args=settings.db.connect_args, # pyright: ignore

)

Criamos um objeto engine que aponta para uma conexão com o banco de

dados e para isso usamos as variáveis que lemos do settings, o objeto settings será capaz de carregar

essas variáveis do ambiente ou dos arquivos .toml que definimos para configuração.

O comentário # pyright: ignore só é necessário caso você esteja usando um editor com LSP que faz verificação

de tipos, como o VSCode ou Neovim. Este comentário faz com que o LSP ignore a checagem de tipos para essas linhas,

e é útil pois como esses valores são dinâmicos podemos receber qualquer tipo.

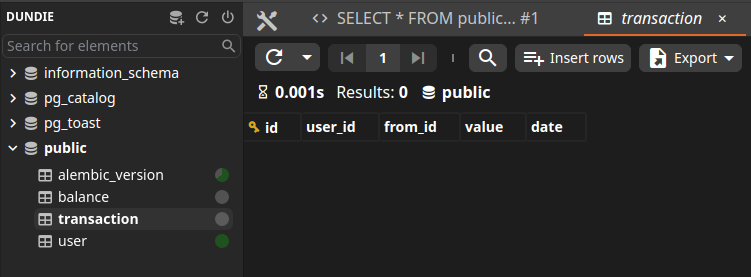

Migrations

Portanto agora já temos uma tabela mapeada e um conexão com o banco de dados precisamos agora garantir que a estrutura da tabela existe dentro do banco de dados.

Para isso vamos usar a biblioteca alembic que gerencia migrações, ou seja,

alterações na estrutura das tabelas e automação de alteração em dados.

Começamos na raiz do repositório, no seu terminal rodando:

alembic init migrations

O alembic irá criar um arquivo chamado alembic.ini e uma pasta chamada migrations que servirá para armazenar o histórico de alterações do banco de dados.

Começaremos editando o arquivo migrations/env.py

Atenção nos comentários do snippet abaixo explicando exatamente onde efetuar cada uma das edições

# 1 - No topo do arquivo adicionamos

from dundie import models

from dundie.db import engine

from dundie.config import settings

# 2 - Perto da linha 23 mudamos de

# target_metadata = None

# para:

target_metadata = models.SQLModel.metadata

# 3 - Na função `run_migrations_offline()` mudamos

# url = config.get_main_option("sqlalchemy.url")

# para:

url = settings.db.uri

# 4 - Na função `run_migration_online` mudamos

# connectable = engine_from_config...

# para:

connectable = engine

Agora precisamos fazer só mais um ajuste

edite migrations/script.py.mako e em torno da linha 10

adicione

#from alembic import op

#import sqlalchemy as sa

import sqlmodel # linha NOVA

Agora sim podemos começar a usar o alembic para gerenciar as migrations, precisamos executar este comando dentro do shell do container.

Executando comandos dentro do container

Todos os comandos a partir de agora serão executados no shell dentro do container e para fazer isso usaremos sempre docker compose exec antes que qualquer comando.

Experimente: docker compose exec api /bin/bash

$ docker compose exec api /bin/bash

app@c5dd026e8f92:~/api$ # este é o shell dentro do container api

# digite exit para sair

Podemos redirecionar comandos diretamente para dentro do container com docker compose exec api [comando a ser executado]

Gerando e aplicando migrations

Agora para gerar um registro inicial de migration usaremos o comando alembic revision --autogenerate e isso será executado dentro do container conforme exemplo abaixo:

$ docker compose exec api alembic revision --autogenerate -m "initial"

INFO [alembic.runtime.migration] Context impl PostgresqlImpl.

INFO [alembic.runtime.migration] Will assume transactional DDL.

INFO [alembic.autogenerate.compare] Detected added table 'user'

Generating /home/app/api/migrations/versions/ee59b23815d3_initial.py ... done

Repare que o alembic identificou o nosso model User e gerou uma migration

inicial que fará a criação desta tabela no banco de dados.

Podemos aplicar a migration rodando dentro do container com alembic upgrade head:

$ docker compose exec api alembic upgrade head

INFO [alembic.runtime.migration] Context impl PostgresqlImpl.

INFO [alembic.runtime.migration] Will assume transactional DDL.

INFO [alembic.runtime.migration] Running upgrade -> ee59b23815d3, initial

E neste momento a tabela será criada no Postgres e já podemos começar a interagir via SQL client ou através da classe User que modelamos anteriormente.

Pode usar um client como https://antares-sql.app para se conectar ao banco de dados, usar o psql na linha de comando ou abrir o shell do ipython dentro do container.

Acessando o banco de dados através do shell

$ docker compose exec api ipython

# Agora está no ipython dentro do shell do container

In [1]:

Digite

from sqlmodel import Session, select

from dundie.db import engine

from dundie.models import User

with Session(engine) as session:

print(list(session.exec(select(User))))

O resultado será uma lista vazia [] indicando que ainda não temos nenhum usuário no banco de dados.

Digite

exitpara sair do ipython.

Foi preciso muito boilerplate para conseguir interagir com banco de dados através do shell portanto para facilitar a nossa vida vamos adicionar uma aplicação cli onde vamos poder executar tarefas administrativas via linha de comando como criar ou listar usuários. -->

Criando a CLI

Command Line Interface é uma parte importante de todo serviço, é através dessa ferramanta que geralmente os administradores do serviço interagem com ele, seja para realizar tarefas de manutenção, configuração ou recuperar o sistema em caso de falhas.

Vamos criar uma CLI para o nosso serviço, para isso vamos usar o typer, que é uma das melhores bibliotecas para criar CLIs em Python.

Começaremos adicionando um comando shell que abrirá um shell interativo com os objetos da aplicação e um outro

comando user-list para listar todos os usuários cadastrados.

EDITE dundie/cli.py

import typer

from rich.console import Console

from rich.table import Table

from sqlmodel import Session, select

from .config import settings

from .db import engine

from .models import User

main = typer.Typer(name="dundie CLI", add_completion=False)

@main.command()

def shell():

"""Opens interactive shell"""

_vars = {

"settings": settings,

"engine": engine,

"select": select,

"session": Session(engine),

"User": User,

}

typer.echo(f"Auto imports: {list(_vars.keys())}")

try:

from IPython import start_ipython

start_ipython(

argv=["--ipython-dir=/tmp", "--no-banner"], user_ns=_vars

)

except ImportError:

import code

code.InteractiveConsole(_vars).interact()

@main.command()

def user_list():

"""Lists all users"""

table = Table(title="dundie users")

fields = ["name", "username", "dept", "email", "currency"]

for header in fields:

table.add_column(header, style="magenta")

with Session(engine) as session:

users = session.exec(select(User))

for user in users:

table.add_row(*[getattr(user, field) for field in fields])

Console().print(table)

E agora podemos executar.

$ docker compose exec api dundie --help

Usage: dundie [OPTIONS] COMMAND [ARGS]...

╭─ Options ──────────────────────────────────────────────────╮

│ --help Show this message and exit. │

╰────────────────────────────────────────────────────────────╯

╭─ Commands ─────────────────────────────────────────────────╮

│ shell Opens interactive shell │

│ user-list Lists all users │

╰────────────────────────────────────────────────────────────╯

E cada um dos comandos:

O comando user-list para listar todos os usuários (que por enquanto irá retornar uma tabela vazia)

$ docker compose exec api dundie user-list

dundie users

┏━━━━━━┳━━━━━━━━━━┳━━━━━━┳━━━━━━━┳━━━━━━━━━━┓

┃ name ┃ username ┃ dept ┃ email ┃ currency ┃

┡━━━━━━╇━━━━━━━━━━╇━━━━━━╇━━━━━━━╇━━━━━━━━━━┩

└──────┴──────────┴──────┴───────┴──────────┘

e o comando shell que irá abrir um shell interativo com os objetos da aplicação.

$ docker compose exec api dundie shell

Auto imports: ['settings', 'engine', 'select', 'session', 'User']

In [1]: session.exec(select(User))

Out[1]: <sqlalchemy.engine.result.ScalarResult at 0x7fb539d5e170>

In [2]: settings.db

Out[2]: <Box: {'connect_args': {}, 'uri': 'postgresql://postgres:postgres@db:5432/dundie', 'echo': False}>

Ainda não temos usuários cadastrados pois ainda está faltando uma parte importante que é o hash de senhas para os usuários, vamos resolver -->

Configurando SECRET_KEY

Precisamos ser capazes de encryptar tokens e gerar hash para as senhas dos usuários e para isso temos alguns requisitos, primeiro precisamos de uma chave secreta em nosso arquivo de settings, esta chave será usada em nosso algoritmo de criptografia quando começarmos a gerar tokens.

EDITE dundie/default.toml e adicione ao final

dundie/default.toml

[default.security]

# Set secret key in .secrets.toml

# SECRET_KEY = ""

ALGORITHM = "HS256"

ACCESS_TOKEN_EXPIRE_MINUTES = 30

REFRESH_TOKEN_EXPIRE_MINUTES = 600

Como explicado no próprio comentário do arquivo default.toml, vamos colocar uma secret key separada

no arquivo .secrets.toml na raiz do repositório, isso é recomendável pois podemos adicionar o

arquivo .secrets.toml ao .gitignore para que ele não seja enviado para o repositório e desta

maneira evitamos expor a chave secreta.

CRIE o arquivo .secrets.toml (na raiz do repositório)

[development]

dynaconf_merge = true

[development.security]

# openssl rand -hex 32

SECRET_KEY = "ONLYFORDEVELOPMENT"

Repare que estamos agora usando a seção environment e isso tem a ver

com o modo como o dynaconf gerencia os settings, esses valores serão

carregados apenas durante a execução em fase de desenvolvimento, em produção

o dynaconf carrega apenas valores das variáveis de ambiente (recomendado) ou

de uma seção similar nomeada [production].

Você pode gerar uma secret key mais segura se quiser usando:

$ python -c "print(__import__('secrets').token_hex(32))"

b9483cc8a0bad1c2fe31e6d9d6a36c4a96ac23859a264b69a0badb4b32c538f8

# OU no Linux

$ openssl rand -hex 32

b9483cc8a0bad1c2fe31e6d9d6a36c4a96ac23859a264b69a0badb4b32c538f8

Garantindo que os settings sempre tenham uma SECRET_KEY

Como a secret key será de extrema importância para o funcionamento da API precisamos garantir que esta chave de configuração esteja sempre presente antes do sistema inicializar.

EDITE dundie/config.py

# No topo faça o import de `Validator`

from dynaconf import Dynaconf, Validator

# No final adicione a validação

settings.validators.register( # pyright: ignore

Validator("security.SECRET_KEY", must_exist=True, is_type_of=str),

)

settings.validators.validate() # pyright: ignore

A partir de agora caso a SECRET_KEY não esteja disponível a aplicação não irá inicializar.

Agora sim podemos adicionar o código para geração de hash do password -->

Criando um hash

Para fazer com que o password dos usuários seja salvo como um hash ao invés de plain-text vamos criar uma função para criar o hash e outra para verificar.

Além disso vamos criar uma classe herdando de str e customizar o método validate

desta forma podemos usar esta classe na definição de campo do nosso model User e

o pydantic vai chamar o método validate para transformar o valor do campo em um hash.

EDITE Agora vamos o dundie/security.py e adicione alguns elementos

"""Security utilities"""

from passlib.context import CryptContext

pwd_context = CryptContext(schemes=["bcrypt"], deprecated="auto")

def verify_password(plain_password, hashed_password) -> bool:

"""Verifies a hash against a password"""

return pwd_context.verify(plain_password, hashed_password)

def get_password_hash(password) -> str:

"""Generates a hash from plain text"""

return pwd_context.hash(password)

class HashedPassword(str):

"""Takes a plain text password and hashes it.

use this as a field in your SQLModel

class User(SQLModel, table=True):

username: str

password: HashedPassword

"""

@classmethod

def __get_validators__(cls):

# one or more validators may be yielded which will be called in the

# order to validate the input, each validator will receive as an input

# the value returned from the previous validator

yield cls.validate

@classmethod

def validate(cls, v):

"""Accepts a plain text password and returns a hashed password."""

if not isinstance(v, str):

raise TypeError("string required")

hashed_password = get_password_hash(v)

# you could also return a string here which would mean model.password

# would be a string, pydantic won't care but you could end up with some

# confusion since the value's type won't match the type annotation

# exactly

return cls(hashed_password)

EDITE agora o arquivo dundie/models/user.py

No topo na linha 4

from dundie.security import HashedPassword

E no model mudamos o campo password na linha 18 para

password: HashedPassword

E no final de dundie/models/user.py uma função para gerar os usernames, transformando nomes completos como Bruno Rocha em um slug como bruno-rocha

def generate_username(name: str) -> str:

"""Generates a slug username from a name"""

return name.lower().replace(" ", "-")

Agora sim está tudo pronto para adicionarmos ao nosso CLI um comando para criar novos usuários -->

Comando para criar usuários

EDITE dundie/cli.py e adicione no topo do arquivo:

from dundie.models.user import generate_username

e no final adicione um novo comando:

@main.command()

def create_user(

name: str,

email: str,

password: str,

dept: str,

username: str | None = None,

currency: str = "USD",

):

"""Create user"""

with Session(engine) as session:

user = User(

name=name,

email=email,

password=password, # pyright: ignore

dept=dept,

username=username or generate_username(name),

currency=currency,

)

session.add(user)

session.commit()

session.refresh(user)

typer.echo(f"created {user.username} user")

return user

A função create_user será exposta na CLI como o subcomando create-user, ou seja, _ será substituido por - então no terminal execute para ver a mensagem de ajuda dundie create-user --help:

$ docker compose exec api dundie create-user --help

Usage: dundie create-user [OPTIONS] NAME EMAIL PASSWORD DEPT

Create user

╭─ Arguments ──────────────────────────────────────╮

│ * name TEXT [default: None] │

│ [required] │

│ * email TEXT [default: None] │

│ [required] │

│ * password TEXT [default: None] │

│ [required] │

│ * dept TEXT [default: None] │

│ [required] │

╰──────────────────────────────────────────────────╯

╭─ Options ────────────────────────────────────────╮

│ --username TEXT [default: None] │

│ --currency TEXT [default: USD] │

│ --help Show this message and │

│ exit. │

╰──────────────────────────────────────────────────╯

E então execute o comando para criar o usuário para o gerente Michael Scott

No terminal quando uma linha fica muito longa podemos adicionar

uma quebra de linha com \ e o terminal vai entender que é uma

única linha.

E no caso de argumentos com espaço como o nome "Michael Scott" precisamos usar aspas para o terminal entender que é um único argumento.

Crie o usuário:

$ docker compose exec api dundie create-user \

"Michael Scott" mscott@dm.com boss123 management

created michael-scott user

E para listar o usuário criado:

$ docker compose exec api dundie user-list

dundie users

┏━━━━━━━━━━━━━━━┳━━━━━━━━━━━━━━━┳━━━━━━━━━━━━┳━━━━━━━━━━━━━━━┳━━━━━━━━━━┓

┃ name ┃ username ┃ dept ┃ email ┃ currency ┃

┡━━━━━━━━━━━━━━━╇━━━━━━━━━━━━━━━╇━━━━━━━━━━━━╇━━━━━━━━━━━━━━━╇━━━━━━━━━━┩

│ Michael Scott │ michael-scott │ management │ mscott@dm.com │ USD │

└───────────────┴───────────────┴────────────┴───────────────┴──────────┘

Agora podemos finalmente começar a criar a nossa API -->

Definindo Serializers

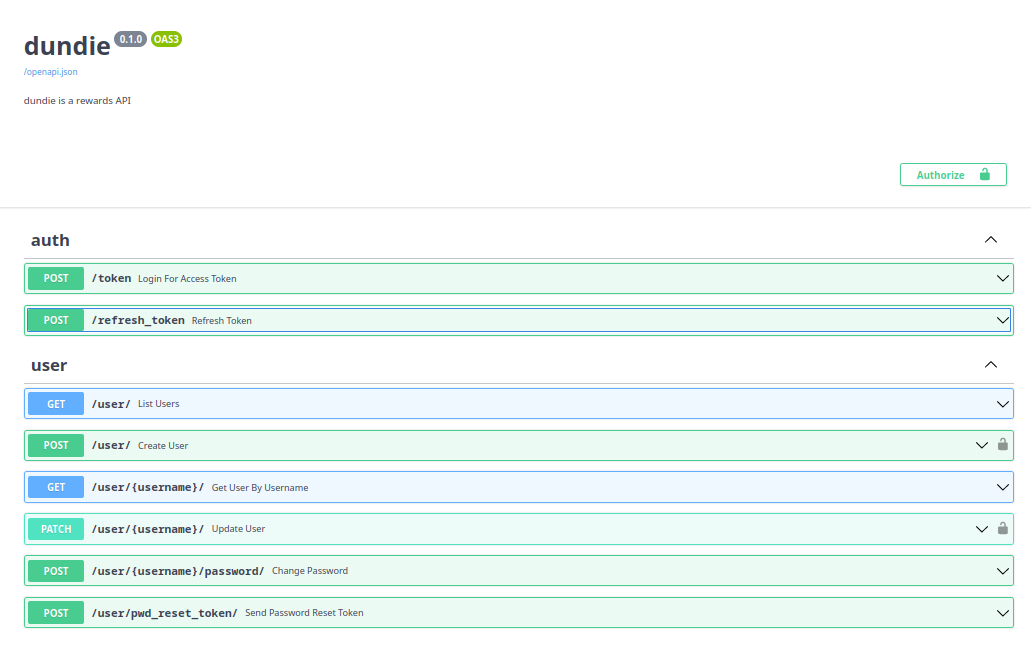

Agora vamos criar endpoints na API para efetuar as operações que fizemos através da CLI, teremos as seguintes rotas:

GET /user/- Lista todos os usuáriosPOST /user/- Cadastro de novo usuárioGET /user/{username}/- Detalhe de um usuário

Serializers

A primeira coisa que precisamos é definir serializers, que são models intermediários usados para serializar e de-serializar dados de entrada e saída da API e eles são necessários pois não queremos export o model do banco de dados diretamente na API e também queremos a possibilidade de serializar campos opcionais dependendo do nível de acesso do usuário, por exemplo, admins poderão ver mais campos que usuários regulares.

EDITE dundie/models/user.py

No topo na linha 5

from pydantic import BaseModel, root_validator

No final após a linha 20

class UserResponse(BaseModel):

"""Serializer for User Response"""

name: str

username: str

dept: str

avatar: Optional[str] = None

bio: Optional[str] = None

currency: str

class UserRequest(BaseModel):

"""Serializer for User request payload"""

name: str

email: str

dept: str

password: str

currency: str = "USD"

username: Optional[str] = None

avatar: Optional[str] = None

bio: Optional[str] = None

@root_validator(pre=True)

def generate_username_if_not_set(cls, values):

"""Generates username if not set"""

if values.get("username") is None:

values["username"] = generate_username(values["name"])

return values

Podemos testar os serializers em nosso shell só para ter certeza do funcionamento correto.

$ docker compose exec api dundie shell

Auto imports: ['settings', 'engine', 'select', 'session', 'User']

In [1]: from dundie.models.user import UserRequest

In [2]: new = UserRequest(

...: name="Bruno Rocha",

...: email="bruno@dm.com",

...: dept="Sales",

...: password="1234",

...: )

In [3]: new.username

Out[3]: 'bruno-rocha'

In [4]: new.currency

Out[4]: 'USD'

In [5]: db_user = User.from_orm(new)

In [6]: session.add(db_user)

In [7]: session.commit()

In [12]: session.exec(select(User).where(User.username=="bruno-rocha")).first()

Out[12]: User(bio=None, email='bruno@dm.com', username='bruno-rocha', name='Bruno Rocha', currency=

'USD', id=2, avatar=None, password='$2b$12$v/1h3sKAFCOuiKuXsThAXOBuny46TPYzKyoaBVisCFHlwaxPlKWpu',

dept='Sales')

Como pode ver acima podemos criar usuários via API e serializar usando o UserRequest e só a partir dele criar a instancia de User que iremos salvar no banco de dados.

E da mesma forma podemos fazer o caminho inverso, serializando do banco de dados para a API em JSON.

In [19]: bruno = session.exec(select(User).where(User.username=="bruno-rocha")).first()

In [20]: from dundie.models.user import UserResponse

In [21]: UserResponse.parse_obj(bruno).json()

Out[21]: '{"name": "Bruno Rocha", "username": "bruno-rocha", "dept": "Sales", "avatar": null, "bio"

: null, "currency": "USD"}'

Injeção de dependência

O FastAPI tem um excelente sistema de injeção de dependêcias, isto é util por exemplo para quando quisermos que um endpoint seja acessivel apenas por usuários administradores, ao invés de colocarmos lógica para verificar o nivel de permissão do usuário diretamente em cada view, podemos criar uma dependência.

Outro exemplo (que vamos aplicar agora) é precisarmos garantir que cada endpoint, ao ter sua função view invocada, uma sessão de conexão com o banco de dados já esteja disponível.

Vamos criar uma dependência chamada ActiveSession que posteriormente será usada

na definição das views.

No topo de dundie/db.py nas linhas 2 e 3

from fastapi import Depends

from sqlmodel import Session, create_engine

No final de dundie/db.py após a linha 13

def get_session():

with Session(engine) as session:

yield session

ActiveSession = Depends(get_session)

O objeto que ActiveSession é uma dependência para rotas do FastAPI

quando usarmos este objeto como parâmetro de uma view o FastAPI

vai executar de forma lazy este objeto e passar o retorno da função

atrelada a ele como argumento da nossa view.

Neste caso teremos sempre uma conexão com o banco de dados dentro de cada

view que marcarmos com session: Session = ActiveSession.

Veremos a seguir como usar esta dependência -->

Criando as Views

Agora criaremos as views (funções) para expor os serializers com os usuários que acessaremos usando a sessão de conexão ao banco de dados.

edite dundie/routes/user.py

from typing import List

from fastapi import APIRouter

from fastapi.exceptions import HTTPException

from sqlmodel import Session, select

from dundie.db import ActiveSession

from dundie.models.user import User, UserRequest, UserResponse

router = APIRouter()

@router.get("/", response_model=List[UserResponse])

async def list_users(*, session: Session = ActiveSession):

"""List all users."""

users = session.exec(select(User)).all()

return users

@router.get("/{username}/", response_model=UserResponse)

async def get_user_by_username(

*, session: Session = ActiveSession, username: str

):

"""Get user by username"""

query = select(User).where(User.username == username)

user = session.exec(query).first()

if not user:

raise HTTPException(status_code=404, detail="User not found")

return user

@router.post("/", response_model=UserResponse, status_code=201)

async def create_user(*, session: Session = ActiveSession, user: UserRequest):

"""Creates new user"""

db_user = User.from_orm(user) # transform UserRequest in User

session.add(db_user)

session.commit()

session.refresh(db_user)

return db_user

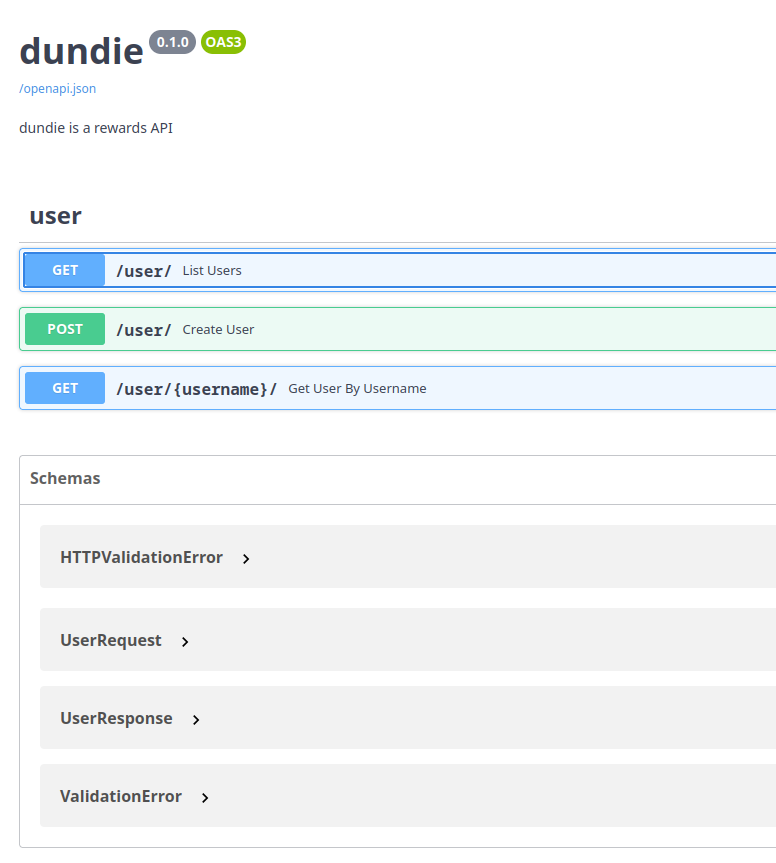

Acima criamos 3 views, uma para listar todos os usuários, uma para listar apenas um usuário e outra para criar um novo usuário.

repare que a rota de criação de um novo usuário temos 2 detalhes diferentes: 1) estamos usando o método post e 2) estamos retornando o status code 201 (criado) em caso de sucesso.

Em todas as views estamos usando os serializers e a injeção de dependência.

Apesar de termos criados as funções, o FastAPI ainda não sabe disso, o próximo passo será fazer o roteamento de URL -->

Roteamento de URL

Com as funções já prontas agora podemos fazer o roteamento, que é o processo

de mapear uma URL como /user/ a uma função como a user_list que criarmos,

ou seja, sempre que o servidor receber um request na URL /user/ irá executar

a função mapeada passando todo o contexto HTTP e o FastAPI se encarrega de fazer

a injeção das dependências.

Vamos começar criando um router principal que irá agrerar todas as rotas:

EDITE dundie/routes/__init__.py

from fastapi import APIRouter

from .user import router as user_router

main_router = APIRouter()

main_router.include_router(user_router, prefix="/user", tags=["user"])

E agora EDITE dundie/app.py

NO topo na linha 4

from .routes import main_router

Logo depois de app = FastAPI(...) após a linha 11

app.include_router(main_router)

E agora sim pode acessar a API e verá as novas rotas prontas para serem usadas, http://0.0.0.0:8000/docs/

Pode tentar pela web interface ou com um http client puro:

# rest_nvim

GET http://localhost:8000/user/

#+END

HTTP/1.1 200 OK

date: Fri, 23 Dec 2022 18:04:23 GMT

server: uvicorn

content-length: 220

content-type: application/json

#+RESPONSE

[

{

"name": "Michael Scott",

"username": "michael-scott",

"dept": "management",

"avatar": null,

"bio": null,

"currency": "USD"

},

{

"name": "Bruno Rocha",

"username": "bruno-rocha",

"dept": "Sales",

"avatar": null,

"bio": null,

"currency": "USD"

}

]

#+END

Ou diretamente via cURL

curl -X 'GET' -k 'http://localhost:8000/user/'

Ou criar um usuário

curl -X 'POST' -H 'Content-Type: application/json' \

--data-raw '{"email": "pam@dm.com", "dept": "Accounting", "password": "jimjim", "name": "Pam Besly"}' \

-k 'http://localhost:8000/user/'

Pegar um usuário pelo username

curl -X 'GET' -k 'http://localhost:8000/user/michael-scott/'

{

"name": "Michael Scott",

"username": "michael-scott",

"dept": "management",

"avatar": null,

"bio": null,

"currency": "USD"

}

Listar todos

curl -X 'GET' \

'http://0.0.0.0:8000/user/' \

-H 'accept: application/json'

[

{

"name": "Michael Scott",

"username": "michael-scott",

"dept": "management",

"avatar": null,

"bio": null,

"currency": "USD"

},

{

"name": "Bruno Rocha",

"username": "bruno-rocha",

"dept": "Sales",

"avatar": null,

"bio": null,

"currency": "USD"

},

{

"name": "Dwight Schrute",

"username": "dwight-schrute",

"dept": "Sales",

"avatar": null,

"bio": null,

"currency": "USD"

},

{

"name": "Pam Besly",

"username": "pam-besly",

"dept": "Accounting",

"avatar": null,

"bio": null,

"currency": "USD"

},

{

"name": "Jim Halpert",

"username": "jim-halpert",

"dept": "Sales",

"avatar": null,

"bio": null,

"currency": "USD"

}

]

Só tem um pequeno problema: Qualquer um consegue criar usuários em nossa API sem estar autenticado e isso não é desejável, vamos resolver este problema implementando autenticação -->

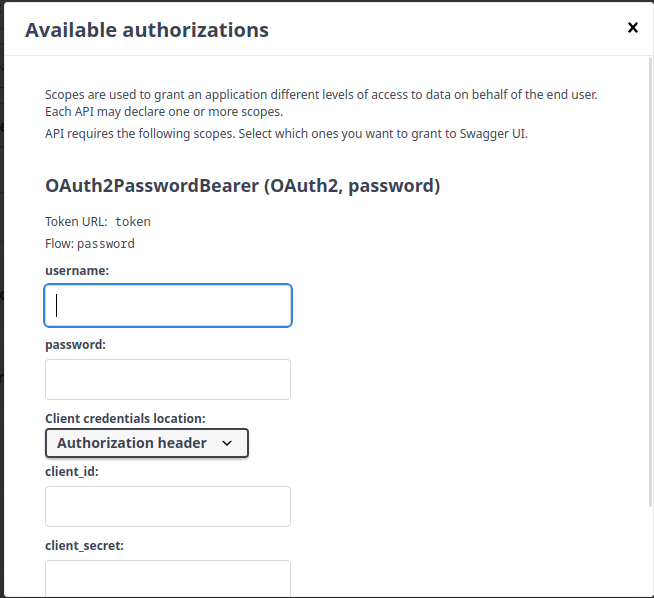

Gerando tokens

Agora que já podemos criar usuários é importante conseguirmos autenticar os usuários pois desta forma podemos limitar o acesso a alguns endpoints.

Esse será arquivo com a maior quantidade de código boilerplate.

EDITE o arquivo dundie/auth.py vamos criar as classes e funções necessárias

para a implementação de JWT que é a autenticação baseada em token e vamos

usar o algoritmo selecionado no arquivo de configuração.

Neste arquivo vamos criar os seguintes objetos:

- Um esquema de autenticação baseado em oauth, este objeto é usado pelo FastAPI para exibir um formulário de login e outros controles de autenticação na página /docs.

- Classes para serializar os 3 tipos de token que criaremos (token, refresh_token, reset_password_token)

- Fução que cria um token usando o algoritmo especificado

- Função que recebe o token e valida sua autenticidade

- Funções para retornar o objeto

Usersempre que precisarmos saber qual usuário está autenticado - Dependência para injetarmos em todas as funções que necessitem de autenticação

dundie/auth.py

"""Token based auth"""

from datetime import datetime, timedelta

from typing import Callable, Optional, Union

from functools import partial

from fastapi import Depends, HTTPException, Request, status

from fastapi.security import OAuth2PasswordBearer

from jose import JWTError, jwt

from pydantic import BaseModel

from sqlmodel import Session, select

from dundie.config import settings

from dundie.db import engine

from dundie.models.user import User

from dundie.security import verify_password

SECRET_KEY = settings.security.secret_key # pyright: ignore

ALGORITHM = settings.security.algorithm # pyright: ignore

oauth2_scheme = OAuth2PasswordBearer(tokenUrl="token")

# Models

class Token(BaseModel):

access_token: str

refresh_token: str

token_type: str

class RefreshToken(BaseModel):

refresh_token: str

class TokenData(BaseModel):

username: Optional[str] = None

# Functions

def create_access_token(

data: dict,

expires_delta: Optional[timedelta] = None,

scope: str = "access_token",

) -> str:

"""Creates a JWT Token from user data

scope: access_token or refresh_token

"""

to_encode = data.copy()

if expires_delta:

expire = datetime.utcnow() + expires_delta

else:

expire = datetime.utcnow() + timedelta(minutes=15)

to_encode.update({"exp": expire, "scope": scope})

encoded_jwt = jwt.encode(

to_encode,

SECRET_KEY, # pyright: ignore

algorithm=ALGORITHM, # pyright: ignore

)

return encoded_jwt

create_refresh_token = partial(create_access_token, scope="refresh_token")

def authenticate_user(

get_user: Callable, username: str, password: str

) -> Union[User, bool]:

"""Authenticate the user"""

user = get_user(username)

if not user:

return False

if not verify_password(password, user.password):

return False

return user

def get_user(username) -> Optional[User]:

"""Get user from database"""

query = select(User).where(User.username == username)

with Session(engine) as session:

return session.exec(query).first()

def get_current_user(

token: str = Depends(oauth2_scheme),

request: Request = None, # pyright: ignore

fresh=False

) -> User:

"""Get current user authenticated"""

credentials_exception = HTTPException(

status_code=status.HTTP_401_UNAUTHORIZED,

detail="Could not validate credentials",

headers={"WWW-Authenticate": "Bearer"},

)

if request:

if authorization := request.headers.get("authorization"):

try:

token = authorization.split(" ")[1]

except IndexError:

raise credentials_exception

try:

payload = jwt.decode(

token,

SECRET_KEY, # pyright: ignore

algorithms=[ALGORITHM] # pyright: ignore

)

username: str = payload.get("sub") # pyright: ignore

if username is None:

raise credentials_exception

token_data = TokenData(username=username)

except JWTError:

raise credentials_exception

user = get_user(username=token_data.username)

if user is None:

raise credentials_exception

if fresh and (not payload["fresh"] and not user.superuser):

raise credentials_exception

return user

# FastAPI dependencies

async def get_current_active_user(

current_user: User = Depends(get_current_user),

) -> User:

"""Wraps the sync get_active_user for sync calls"""

return current_user

AuthenticatedUser = Depends(get_current_active_user)

async def validate_token(token: str = Depends(oauth2_scheme)) -> User:

"""Validates user token"""

user = get_current_user(token=token)

return user

O objeto AuthenticatedUser é uma dependência do FastAPI e é

através dele que iremos garantir que nossas rotas estejas protegidas

com token.

Agora só falta registrarmos as URLs responsáveis por gerar a validar o token -->

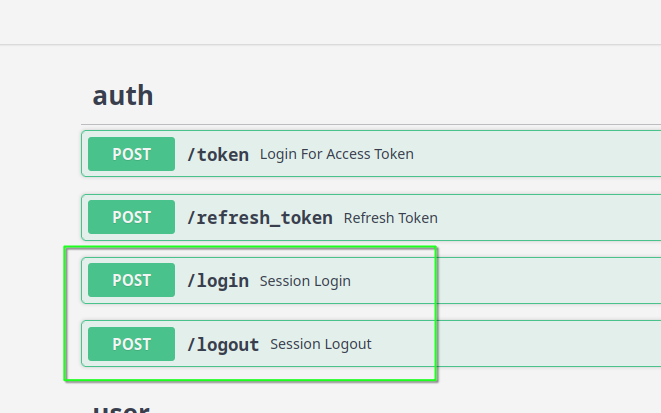

Criando Endpoints de Auth

Agora precisamos mapear a função de geração e validação de tokens na API, expondo a

URL /token para que possamos gerar um token para um usuário.

EDITE dundie/routes/auth.py

from datetime import timedelta

from fastapi import APIRouter, Depends, HTTPException, status

from fastapi.security import OAuth2PasswordRequestForm

from dundie.auth import (

RefreshToken,

Token,

User,

authenticate_user,

create_access_token,

create_refresh_token,

get_user,

validate_token,

)

from dundie.config import settings

ACCESS_TOKEN_EXPIRE_MINUTES = settings.security.access_token_expire_minutes # pyright: ignore

REFRESH_TOKEN_EXPIRE_MINUTES = settings.security.refresh_token_expire_minutes # pyright: ignore

router = APIRouter()

@router.post("/token", response_model=Token)

async def login_for_access_token(

form_data: OAuth2PasswordRequestForm = Depends(),

):

user = authenticate_user(get_user, form_data.username, form_data.password)

if not user or not isinstance(user, User):

raise HTTPException(

status_code=status.HTTP_401_UNAUTHORIZED,

detail="Incorrect username or password",

headers={"WWW-Authenticate": "Bearer"},

)

access_token_expires = timedelta(minutes=ACCESS_TOKEN_EXPIRE_MINUTES) # pyright: ignore

access_token = create_access_token(

data={"sub": user.username, "fresh": True},

expires_delta=access_token_expires,

)

refresh_token_expires = timedelta(minutes=REFRESH_TOKEN_EXPIRE_MINUTES) # pyright: ignore

refresh_token = create_refresh_token(

data={"sub": user.username}, expires_delta=refresh_token_expires

)

return {

"access_token": access_token,

"refresh_token": refresh_token,

"token_type": "bearer",

}

@router.post("/refresh_token", response_model=Token)

async def refresh_token(form_data: RefreshToken):

user = await validate_token(token=form_data.refresh_token)

access_token_expires = timedelta(minutes=ACCESS_TOKEN_EXPIRE_MINUTES) # pyright: ignore

access_token = create_access_token(

data={"sub": user.username, "fresh": False},

expires_delta=access_token_expires,

)

refresh_token_expires = timedelta(minutes=REFRESH_TOKEN_EXPIRE_MINUTES) # pyright: ignore

refresh_token = create_refresh_token(

data={"sub": user.username}, expires_delta=refresh_token_expires

)

return {

"access_token": access_token,

"refresh_token": refresh_token,

"token_type": "bearer",

}

E agora vamos adicionar essas URLS ao router principal

EDITE dundie/routes/__init__.py

No topo na linha 3

from .auth import router as auth_router

E depois na linha 9

main_router.include_router(auth_router, tags=["auth"])

Vamos testar a aquisição de um token via curl. (ou pode utilizar algum outro cliente HTTP de sua preferencia como o Imsomnia ou Postman)

curl -X 'POST' \

'http://localhost:8000/token' \

-H 'accept: application/json' \

-H 'Content-Type: application/x-www-form-urlencoded' \

-d 'username=michael-scott&password=boss123'

passe como parametro os dados de um usuário que tenha criado via linha de comando.

Resposta:

{

"access_token": "eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiJhZG1pbiIsImZyZXNoIjp0cnVlLCJleHAiOjE2Njg2Mjg0NjgsInNjb3BlIjoiYWNjZXNzX3Rva2VuIn0.P-F3onD2vFFIld_ls1irE9rOgLNk17SNDASls31lgkU",

"refresh_token": "eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiJhZG1pbiIsImV4cCI6MTY2ODY2MjY2OCwic2NvcGUiOiJyZWZyZXNoX3Rva2VuIn0.AWV8QtySYmcukxTgTa9GedLK00o6wrbyMt9opW42eyQ",

"token_type": "bearer"

}

agora sim já conseguimos gerar o token, só falta proteger as URLs -->

Protegendo rotas

Apenas super usuários terão permissão para criar novos usuários, portanto

vamos proteger a view POST /user/ com autenticação via TOKEN

EDITE dundie/auth.py e adicione no final uma dependencia para

garantir que o usuário autenticado é super usuário.

async def get_current_super_user(

current_user: User = Depends(get_current_user),

) -> User:

if not current_user.superuser:

raise HTTPException(

status_code=status.HTTP_403_FORBIDDEN, detail="Not a super user"

)

return current_user

SuperUser = Depends(get_current_super_user)

Agora vamos usar essa dependencia para garantir o super usuário em nossa rota

EDITE dundie/routes/user.py

No topo próximo a linha 9

from dundie.auth import SuperUser

E no roteamento da view create_user como parametro para o decorator .post passamos uma lista de

dependencias que sejam satisfeitas pelo FAstAPI antes de executar o código da view, ou seja, o código só será executado caso o usuário autenticado via token seja um superusuário.

@router.post("/", response_model=UserResponse, status_code=201, dependencies=[SuperUser])

async def create_user(*, session: Session = ActiveSession, user: UserRequest):

...

Como adicionamos dependencies=[SuperUser] no roteamento e isso é o suficiente para o FastAPI detectar que existe pelo menos uma URL que necessita de autenticação e agora já teremos os controles de autenticação na API.

Ao tentar criar um usuário sem autenticar teremos agora um erro HTTP_401_UNAUTHORIZED e se o usuário autenticado não for um superuser termos o erro HTTP_403_FORBIDDEN

Os requests vão precisar do token, portanto o usuário primeiro precisa pedir um token na URL /token e depois usar este token na requisição protegida

curl -X 'POST' \

'http://localhost:8000/user/?fresh=false' \

-H 'accept: application/json' \

-H 'Authorization: Bearer eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiJtaWNoYWVsLXNjb3R0IiwiZnJlc2giOnRydWUsImV4cCI6MTY3MTgyOTc2NCwic2NvcGUiOiJhY2Nlc3NfdG9rZW4ifQ.wdIUyJS9TX2Ku8BMI_AIJhAXQb-TSHmX11qKs5C4PF0' \

-H 'Content-Type: application/json' \

-d '{

"name": "Kevin Malone",

"email": "kevin@dm.com",

"dept": "Sales",

"password": "stacy"

}'

Erros HTTP

Quando as coisas dão errado precisamos informar o cliente HTTP com o código de status correto, erros podem acontecer quando ocorre uma falha inesperada no servidor, quando o recurdo solicitado não existe ou quando o cliente efetua uma requisição inválida.

Vamos tentar duplicar a criação de um usuário fazendo novamente a mesma chamada POST e a mensagem que receberemos é:

Faça essa chamada mais de 1x:

curl -X 'POST' -H 'Content-Type: application/json' \

--data-raw '{"email": "pam@dm.com", "dept": "Accounting", "password": "jimjim", "name": "Pam Besly"}' \

-k 'http://localhost:8000/user/'

HTTP/1.1 500 Internal Server Error

Internal Server Error

A mensagem de erro não ajuda muito a sabermos o que ocorreu de fato e portanto podemos curtomizar este comportamento.

Quando temos este caso expecifico o código de erro correto é o 409 Conflict que innforma que o estado interno está em conflito com o estado que está sendo enviado no request, ou seja, estamos tentando criar um usuário que já existe.

Para customizar este comportamento podemos editar o arquivo routes/user.py

# No topo

from sqlalchemy.exc import IntegrityError

# Na função `create_user`

async def create_user(.......):

...

try:

session.commit()

except IntegrityError:

raise HTTPException(status_code=409, detail="User already exists")

A exception IntegrityError será levantada para qualquer problemas encontrado no banco de dados portanto não é ainda a melhor opção, precisamos ser mais especificos para ajudar quem está usando a API, portanto vamos fazer as seguintes modificações:

- Continuar tratando a IntegrityError porém com o código 500 e mensagem de erro genérica.

- Adicionar um guard para garantir que o usuário a ser criado não existe.

@router.post(

"/", response_model=UserResponse, status_code=201, dependencies=[SuperUser]

)

async def create_user(*, session: Session = ActiveSession, user: UserRequest):

"""Creates new user"""

if session.exec(select(User).where(User.username == user.username)).first():

raise HTTPException(status_code=409, detail="Username already taken")

db_user = User.from_orm(user) # transform UserRequest in User

session.add(db_user)

try:

session.commit()

except IntegrityError:

raise HTTPException(status_code=500, detail="Database IntegrityError")

session.refresh(db_user)

return db_user

E agora sim teremos o retorno esperado

HTTP/1.1 409 Conflict

Username already taken

E no caso de um outro erro de integridade ai invés de mostrar apenas o erro 500 genérico informamos especificamente que se trata de um problema no banco de dados, porém sem expor o erro diretamente.

Uma boa prática seria colocar um logger ou um analisador de exceptions como o NewRelic ou o Sentry, faremos isso em outra parte do treinamento.

Vamos agora continuar implementando as rotas de usuário -->

Update User

Agora vamos adicionar uma rota para que o usuário possa alterar o próprio perfil.

O usuário será capaz de mudar apenas os campos bio e avatar

bio será um texto e avatar a URL de uma imagem, e é claro, o usuário só

poderá alterar o seu próprio perfil.

Vamos começar criando o serializer que irá receber essas informações a serem alteradas:

EDITE models/user.py e adicione:

class UserProfilePatchRequest(BaseModel):

avatar: Optional[str] = None

bio: Optional[str] = None

E agora EDITE routes/user.py e adicione ao final.

@router.patch("/{username}/", response_model=UserResponse)

async def update_user(

*,

session: Session = ActiveSession,

patch_data: UserProfilePatchRequest,

current_user: User = AuthenticatedUser,

username: str

):

user = session.exec(select(User).where(User.username == username)).first()

if not user:

raise HTTPException(status_code=404, detail="User not found")

if user.id != current_user.id and not current_user.superuser:

raise HTTPException(status_code=403, detail="You can only update your own profile")

# Update

user.avatar = patch_data.avatar

user.bio = patch_data.bio

session.add(user)

session.commit()

session.refresh(user)

return user

Agora podemos testar a rota fazendo a alteração do perfil do usuário michael-scott, lembre-se que primeiro

será necessário obter um token válido com uma chamada na rota /token

curl -X 'PATCH' \

-H 'Authorization: Bearer ...' \

-H 'Content-Type: application/json'

--data-raw '{"avatar": "https://test.com/MichaelScott.png", "bio": "I am the boss"}' \

-k 'http://localhost:8000/user/michael-scott/'

O usuário também precisará alterar a senha caso ele esqueça, vamos implementar esta funcionalidade -->

Change Password

O endpoint de alteração de senha precisa ficar separado do perfil pois este endpoint precisa de alguns detalhes extras:

- O usuário precisa preencher a senha e a confirmação

- A mudança pode ser feita pelo próprio usuário, pelo superuser ou através de um token requisitado por email (funcionalidade de esqueci a senha)

Começamos adicionando o serializer para receber o request da alteração do password.

EDITE models/user.py

# No topo

from fastapi import HTTPException, status

from dundie.security import get_password_hash

...

# No final

class UserPasswordPatchRequest(BaseModel):

password: str

password_confirm: str

@root_validator(pre=True)

def check_passwords_match(cls, values):

"""Checks if passwords match"""

if values.get("password") != values.get("password_confirm"):

raise HTTPException(

status_code=status.HTTP_400_BAD_REQUEST,

detail="Passwords do not match"

)

return values

@property

def hashed_password(self) -> str:

"""Returns hashed password"""

return get_password_hash(self.password)

Para editar o password do usuário teremos as seguintes condições

# O usuário pode editar o próprio password

current_user == user

# O usuário pode editar o password de outro usuário se for superuser

current_user.supersuser is True

# ou se o usuário tiver um token válido

Query("?pwd_reset_token") is valid

Vamos implementar a lógica acima como uma dependencia do FastAPI, usaremos esta dependencia na rota de alteração de senha e a dependência irá garantir que pelo menos um dos requisitos seja satisfeito.

EDITE dundie/auth.py e no final:

async def get_user_if_change_password_is_allowed(

*,

request: Request,

pwd_reset_token: Optional[str] = None, # from path?pwd_reset_token=xxxx

username: str, # from /path/{username}

) -> User:

"""Returns User if one of the conditions is met.

1. There is a pwd_reset_token passed as query parameter and it is valid OR

2. authenticated_user is supersuser OR

3. authenticated_user is User

"""

target_user = get_user(username) # The user we want to change the password

if not target_user:

raise HTTPException(status_code=404, detail="User not found")

try:

valid_pwd_reset_token = get_current_user(token=pwd_reset_token or "") == target_user

except HTTPException:

valid_pwd_reset_token = False

try:

authenticated_user = get_current_user(token="", request=request)

except HTTPException:

authenticated_user = None

if any(

[

valid_pwd_reset_token,

authenticated_user and authenticated_user.superuser,

authenticated_user and authenticated_user.id == target_user.id,

]

):

return target_user

raise HTTPException(

status_code=status.HTTP_403_FORBIDDEN,

detail="You are not allowed to change this user's password",

)

CanChangeUserPassword = Depends(get_user_if_change_password_is_allowed)

Agora temos CanChangeUserPassword como dependencia para usar em uma rota do FastAPI

isso vai garantir que a URL só será executada se todas as condições da dependencia foram

resolvidas.

E agora em routes/user.py vamos criar uma rota com o método POST

O ideal para seguir a semantica REST seria criar este método como PATCH porém formulários HTML permitem apenas GET e POST e para facilitar o trabalho do front-end vamos usar POST.

@router.post("/{username}/password/", response_model=UserResponse)

async def change_password(

*,

session: Session = ActiveSession,

patch_data: UserPasswordPatchRequest,

user: User = CanChangeUserPassword

):

user.password = patch_data.hashed_password # pyright: ignore

session.add(user)

session.commit()

session.refresh(user)

return user

Agora podemos testar a rota de alteração de senha, autenticando com o token válido para o usuário michael-scott por exemplo:

curl -X 'POST' \

-H 'Authorization: Bearer ...' \

-H 'Content-Type: application/json'

--data-raw '{"password": "boss1234", "password_confirm": "boss1234"}' \

-k 'http://localhost:8000/user/michael-scott/password/'

O usuário michael-scott sendo um superuser, também tem permissão para alterar senha de outros usuários,

Agora imagine que um usuário esqueceu a própria senha, mas ao invés de pedir para o gerente ele quer ele mesmo alterar a senha, para isso vamos criar um endpoint para enviar um email com um token válido para alterar a senha e acessar o mesmo endpoint. -->

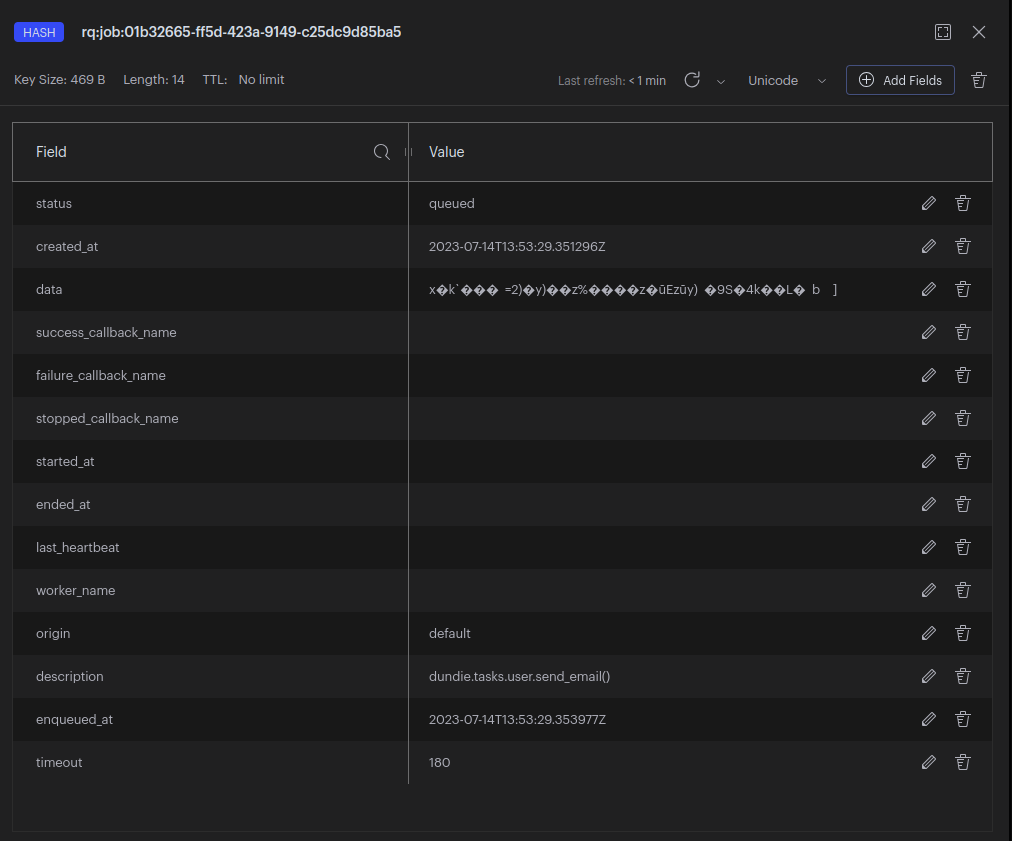

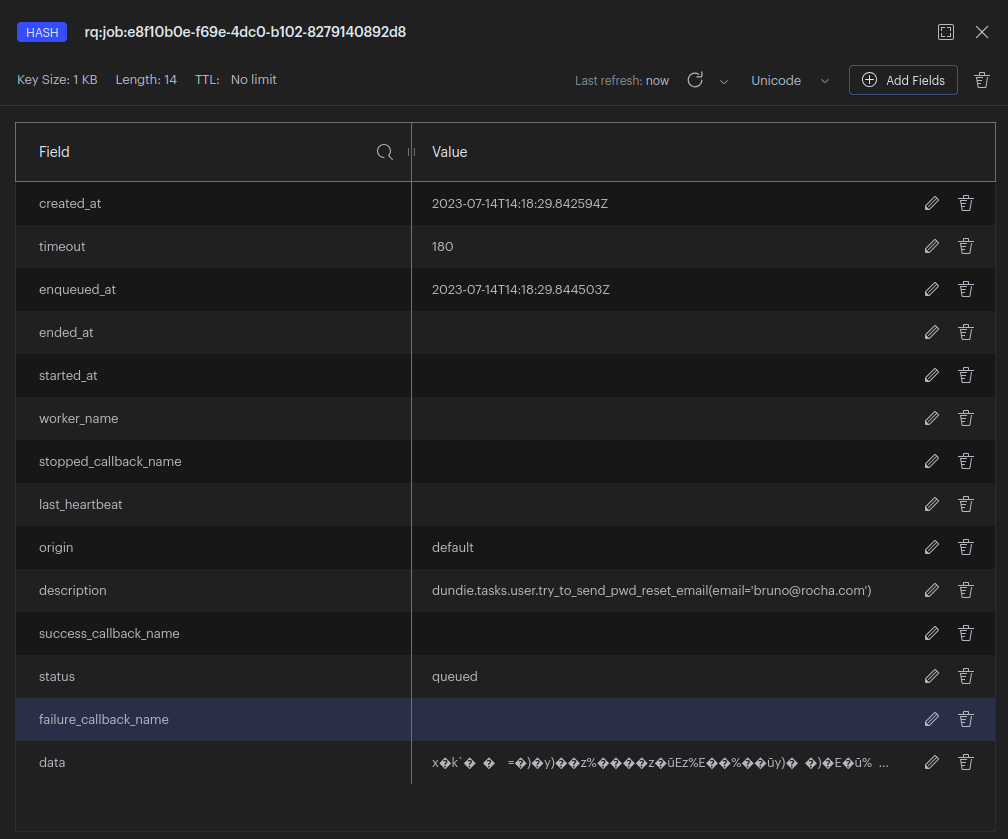

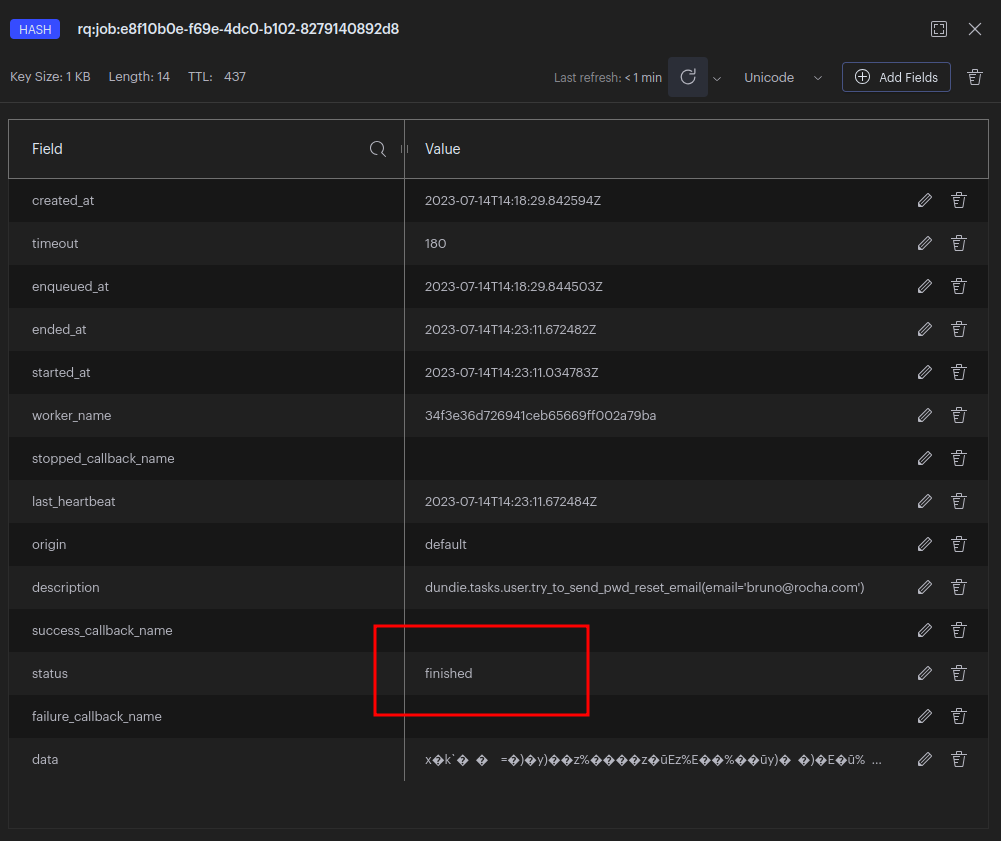

Esqueci minha senha

O próximo passo para completar a gestão de usuários é criarmos uma URL onde o usuário irá informar o seu email e o sistema vai verificar se existe um usuário com este e-mail cadastrado e então enviar um e-mail com o token para permitir a alteração de senha.

Nós já temos uma função que é capaz de gerar um token em dundie/auth.py chamada create_access_token

E vamos usar esta função para gerar o token de alteração de senha.

O fluxo será o seguinte:

- Usuário requisita um token de senha em :

POST /user/pwd_reset_token/

{

"email": "michael-scott@dm.com"

}

Response: 200 Ok

"Email will be sent if user is registered"

- A view roteada em

/user/pwd_reset_tokenvai fazer o seguinte:

- Invocar a função:

try_to_send_pwd_reset_email(email).

-

A função

try_to_send_pwd_reset_emailirá fazer o seguinte: -

Procurar o usuário pelo e-mail

-

Criar um token com expiração curta (o tempo de expiração será definido nos settings)

-

Renderizar um template com o link para redefinir senha

-

Enviar o e-mail

Enviando Email

Vamos começar criando uma função que irá receber alguns parametros e enviar um e-mail, teremos uma versão da função que de fato envia um e-mail via HTTP, e teremos outra que apenas escreve a mensagem em um arquivo de log simulando o envio de e-mail que será útil para testes.

EDITE dundie/tasks/user.py

import smtplib

from datetime import timedelta

from time import sleep

from sqlmodel import Session, select

from dundie.auth import create_access_token

from dundie.config import settings

from dundie.db import engine

from dundie.models.user import User

def send_email(email: str, message: str):

if settings.email.debug_mode is True: # pyright: ignore

_send_email_debug(email, message)

else:

_send_email_smtp(email, message)

def _send_email_debug(email: str, message: str):

"""Mock email sending by printing to a file"""

with open("email.log", "a") as f:

sleep(3) # pretend it takes 3 seconds

f.write(f"--- START EMAIL {email} ---\n" f"{message}\n" "--- END OF EMAIL ---\n")

def _send_email_smtp(email: str, message: str):

"""Connect to SMTP server and send email"""

with smtplib.SMTP_SSL(

settings.email.smtp_server, settings.email.smtp_port # pyright: ignore # pyright: ignore

) as server:

server.login(settings.email.smtp_user, settings.email.smtp_password) # pyright: ignore

server.sendmail(

settings.email.smtp_sender, # pyright: ignore

email,

message.encode("utf8"),

)

MESSAGE = """\

From: Dundie <{sender}>

To: {to}

Subject: Password reset for Dundie

Please use the following link to reset your password:

{url}?pwd_reset_token={pwd_reset_token}

This link will expire in {expire} minutes.

"""

def try_to_send_pwd_reset_email(email):

"""Given an email address sends email if user is found"""

with Session(engine) as session:

user = session.exec(select(User).where(User.email == email)).first()

if not user:

return

sender = settings.email.smtp_sender # pyright: ignore

url = settings.security.PWD_RESET_URL # pyright: ignore

expire = settings.security.RESET_TOKEN_EXPIRE_MINUTES # pyright: ignore

pwd_reset_token = create_access_token(

data={"sub": user.username},

expires_delta=timedelta(minutes=expire), # pyright: ignore

scope="pwd_reset",

)

send_email(

email=user.email,

message=MESSAGE.format(

sender=sender,

to=user.email,

url=url,

pwd_reset_token=pwd_reset_token,

expire=expire,

),

)

O próximo passo é editar o arquivo dundie/default.toml e adicionar os settings necessários para o serviço de emails.

[default.security]

...

RESET_TOKEN_EXPIRE_MINUTES = 10

PWD_RESET_URL = "https://dm.com/reset_password"

[default.email]

debug_mode = true

smtp_sender = "no-reply@dm.com"

smtp_server = "localhost"

smtp_port = 1025

smtp_user = "<replace in .secrets.toml>"

smtp_password = "<replace in .secrets.toml>"

Agora podemos abrir um terminal e testar essas funções

$ docker compose exec api dundie shell

Auto imports: ['settings', 'engine', 'select', 'session', 'User']

In [1]: from dundie.tasks.user import try_to_send_pwd_reset_email

In [2]: try_to_send_pwd_reset_email("mscott@dm.com") # wait 3 seconds

In [3]: open("email.log").readlines()

Out[3]:

['--- START EMAIL mscott@dm.com ---\n',

'From: Dundie <no-reply@dm.com>\n',

'To: mscott@dm.com\n',

'Subject: Password reset for Dundie\n',

'\n',

'Please use the following link to reset your password:\n',

'https://dm.com/reset_password?pwd_reset_token=eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJzdWIiOiJtaWNoYWVsLXNjb3R0IiwiZXhwIjoxNjcyNjc3OTk1LCJzY29wZSI6InB3ZF9yZXNldCJ9.nAZNxHYniofTSCzBh38gPi5Qd0FoKONw1Ge6Yp40l5s\n',

'\n',

'This link will expire in 10 minutes.\n',

'\n',

'--- END OF EMAIL ---\n']

Cada e-mail enviado será adicionado ao arquivo email.log enquanto settings.email.debug_mode estiver ativado, futuramente podemos colocar os dados de um servidor smtp de verdade.

Agora a parte principal é criar uma rota que permitirá ao usuário solicitar o token de alteração de senha e disparar a task em background para o envio do e-mail.

EDITE dundie/routes/user.py e no final vamos adicionar.

# import

from dundie.tasks.user import try_to_send_pwd_reset_email

# view

@router.post("/pwd_reset_token/")

async def send_password_reset_token(*, email: str = Body(embed=True)):

"""Sends an email with the token to reset password."""

try_to_send_pwd_reset_email(email)

return {

"message": "If we found a user with that email, we sent a password reset token to it."

}

Neste endpoint estamos recebendo email apenas no corpo do request, ao invés de criarmos um

serializer apenas para armazenar esta informação podemos usar o serializer genérico Body que

permite receber o valor de um campo diretamente no corpo do request.

No caso de um endereço de em-mail pode ser interessante criar um serializer para efetuar a verificando que o e-mail é valido, mas isso fica como melhoria para depois.

Testando:

curl -X 'POST' -H 'Content-Type: application/json' \

--data-raw '{"email": "mscott@dm.com"}' -k \

'http://localhost:8000/user/pwd_reset_token/'

POST http://localhost:8000/user/pwd_reset_token/

#+END

HTTP/1.1 200 OK

date: Mon, 02 Jan 2023 16:42:56 GMT

server: uvicorn

content-length: 87

content-type: application/json

#+RESPONSE

{

"message": "If we found a user with that email, we sent a password reset token to it."

}

#+END

Você pode agora verificar o conteúdo do arquivo email.log para ver se a mensagem foi realmente enviada.

$ cat email.log

...

No arquivo dundie/tasks/user.py estamos criando uma string MESSAGE para usar como template para o e-mail enviado,

mas seria ideal salvar essa string em um arquivo separado, por exemplo pwd_reset_email_template.jinja

e então usar o jinja2 para renderizar o template, lembre-se que usamos o Jinja2 no Day1 do treinamento.

Consegue fazer esta alteração?

Por questões de privacidade nós não podemos confirmar se a operação deu certo, o usuário terá que verificar na caixa de e-mail que em nosso caso é o arquivo de log.

Mas repare que ao chamar a URL precisamos esperar 3 segundos pela resposta, o ideal é que o request seja imediato e a função

taks.try_to_send_pwd_reset_email seja executada em background. -->

Enviando emails assíncronos

Ao chamar a URL /user/pwd_reset_token/ a resposta demorou 3 segundos pois estamos bloqueando o request até o e-mail ser enviado, o ideal é que isso seja feito em background, vamos transformar a chamada de try_to_send_pwd_reset_email em uma task.

O FastAPI tem uma classe chamada BackgroundTasks que nos permite adicionar funções que serão executadas em background, vamos importá-la e adicioná-la como um parâmetro da nossa rota.

As funções que adicionarmos a background_tasks serão adicionadas ao event-loop assíncrono gerenciado pelo FastAPI, desta forma não será necessário esperar o tempo de envio do e-mail, podemos retornar a resposta para o cliente e mesmo depois do request terminado a tarefa continuará executando do lado servidor.

EDITE dundie/routes/user.py

# No topo

from fastpi import BackgroundTasks

...

# Na função

@router.post("/pwd_reset_token/")

async def send_password_reset_token(

*,

email: str = Body(embed=True),

background_tasks: BackgroundTasks, # NEW

):

background_tasks.add_task(try_to_send_pwd_reset_email, email=email) # NEW

return {

"message": "If we found a user with that email, we sent a password reset token to it."

}

Pode testar repetindo a mesma chamada anterior (ou usando a UI em /docs/)

curl -X 'POST' -H 'Content-Type: application/json' \

--data-raw '{"email": "mscott@dm.com"}' -k \

'http://localhost:8000/user/pwd_reset_token/'

Repare que agora a resposta é instantânea e o e-mail é enviado em background.

Assim terminamos a API de gestão de usuários e Auth por enquanto

A tareda de envio de e-mail é bastante simples e não muito complexa em questões de resiliência a falhas, se o e-mail falhar o envio, o usuário simplesmente não vai receber e portanto irá tentar novamente.

Existem casos onde as tarefas precisam de um pouco mais de robustes e controles como retry e auditoria, neste caso usaremos um gerenciador de filas como Celery ou Python-RQ, mas isso veremos adiante.

Com estas rotas agora já podemos ter um front-end integrado para a gestão de usuários, mas o nosso próximo passo será cuidar da API de transações -->

Modelagem de dados

A modelagem dos dados será a seguinte (considerando que já concluimos a tabela de User), fica faltando implementar as outras 2 tabelas.

https://dbdesigner.page.link/GqDU95ApwZs7a9RH9

Portanto criaremos os models para Transaction e Balance

EDITE dundie/models/transaction.py

from datetime import datetime

from typing import TYPE_CHECKING, Optional

from sqlmodel import Field, Relationship, SQLModel

if TYPE_CHECKING:

from dundie.models.user import User

class Transaction(SQLModel, table=True):

"""Represents the Transaction Model"""

id: Optional[int] = Field(default=None, primary_key=True)

user_id: int = Field(foreign_key="user.id", nullable=False)

from_id: int = Field(foreign_key="user.id", nullable=False)

value: int = Field(nullable=False)